2026-03-02 13:52:16

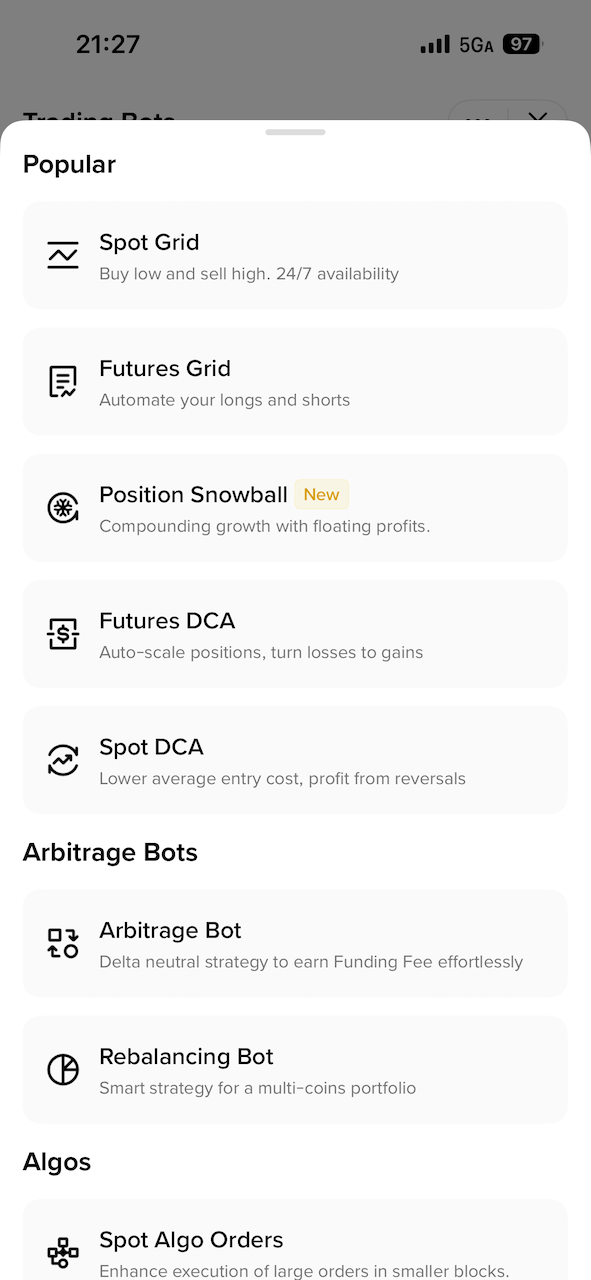

资金费率套利是一种没有风险、保本的套利方式。我一开始尝试自己写脚本来运行策略,然后发现 Binance 直接提供了 bot 来进行这种操作:

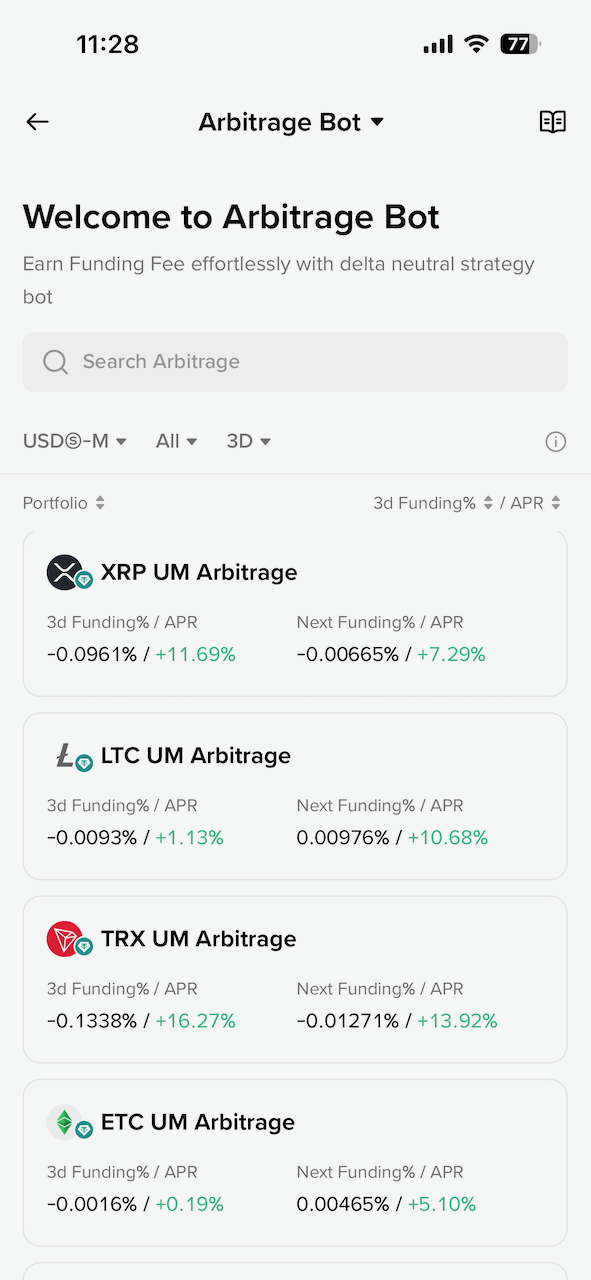

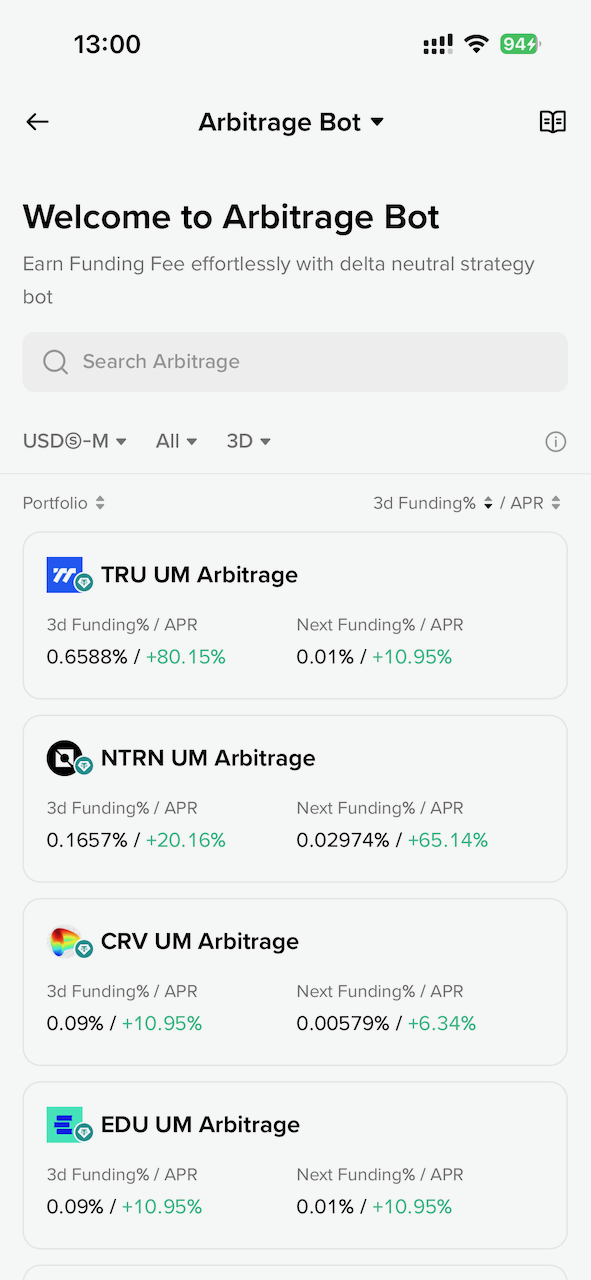

这里的 Arbitrage Bot 就是资金费率套利的 Bot,点开可以看到有很多币种可以选,包括按照资金费率来排序等。而且 Binance 的 Bot 做的很好,如果资金费率是正的,就开正向的套利策略(使用 USDT),如果资金费率是负的,就开反向的策略(使用代币)。

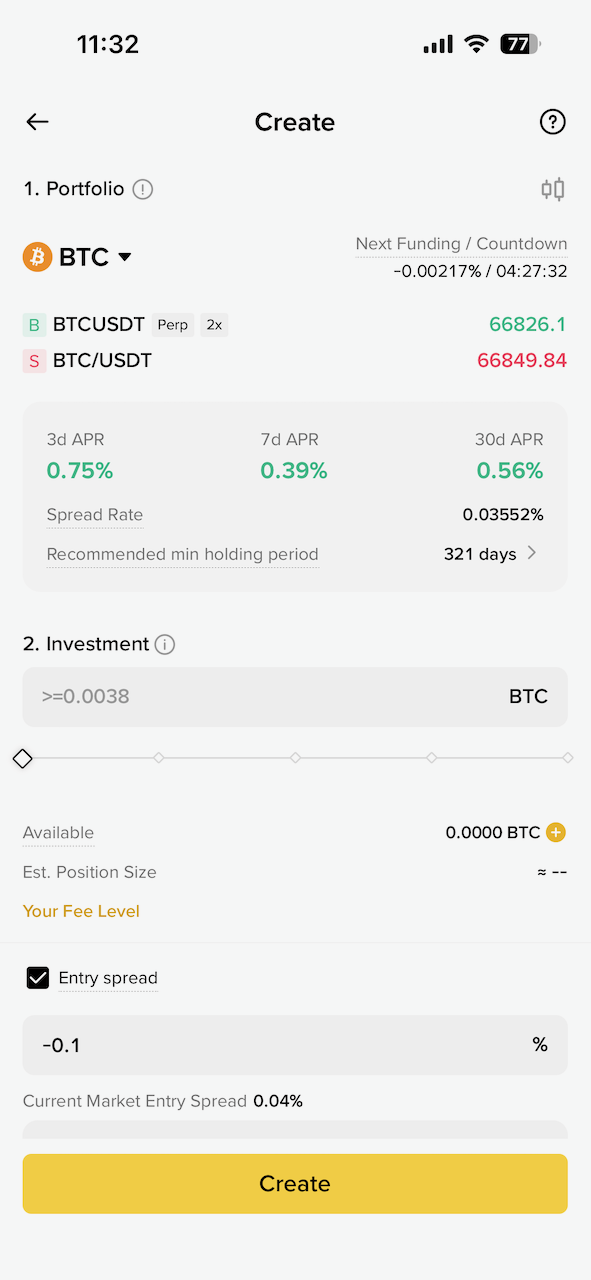

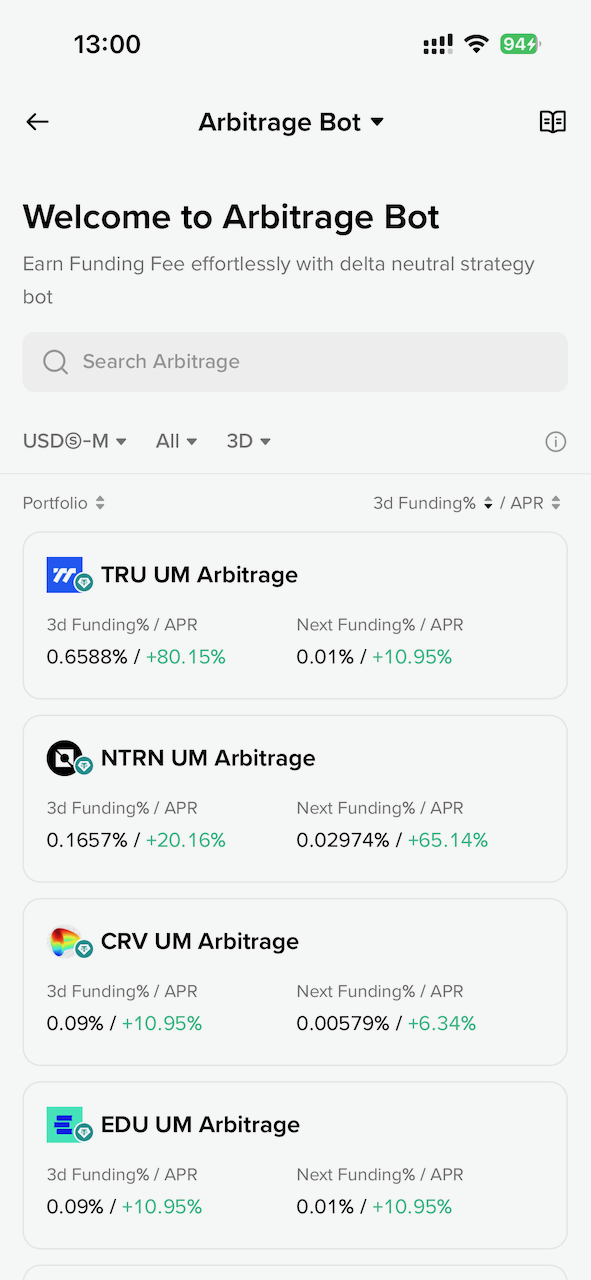

资金费率套利的获利空间很小,如果是 BTC 等主流币种,APR 在 1% 以下,并且也许持有 300 天以上才能磨平手续费损耗。实际上是很不划算的方式。而如果按照资金费率排序,选最高的一个代币,APR 能相对高一点,也许能达到 40% 甚至更多:

资金费率套利是 Detla 中性的,假如代币突然暴涨,把 2 倍的做多合约给爆仓了,会不会导致损失一半本金呢?不会,因为现货涨了 2 倍后卖掉正好抵消了爆仓的损失,所以本金没有变化,整个过程就是赚了这段时间的资金费率。

所以根据资金费率高的代币排序,然后开套利 Bot,是我目前唯一在尝试的赚点利息的方式。

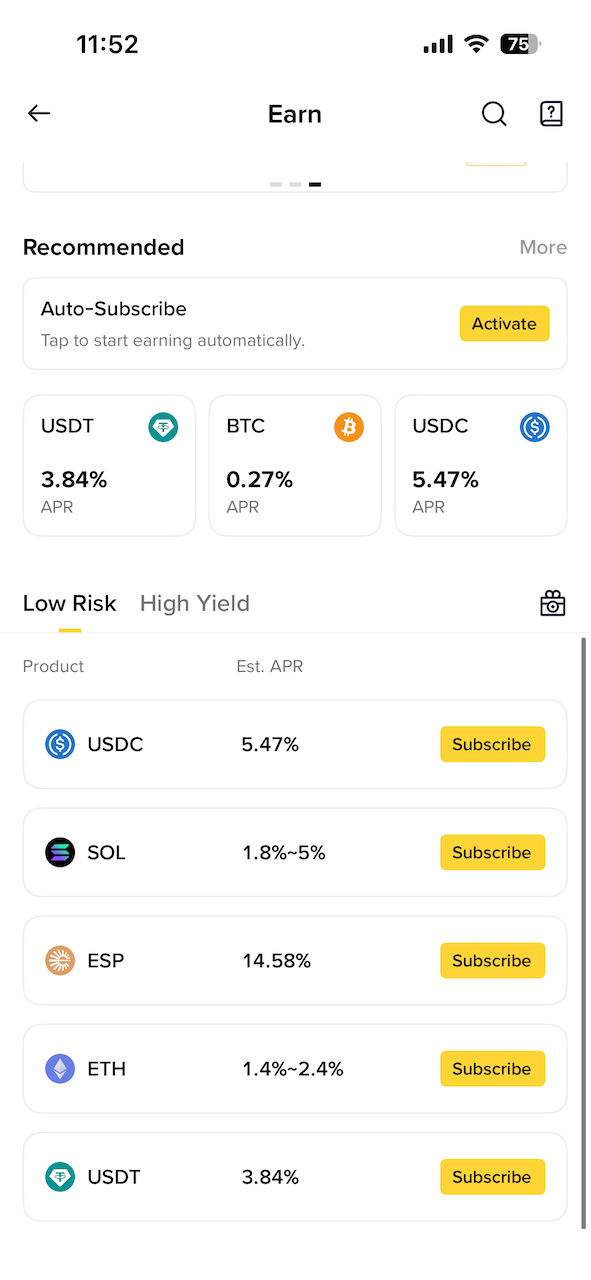

Simple Earn 很简单,存到 Binance 里赚利息。问题在于 APR 并不高,USDC 也就 6%,而且有非常高的额度限制,只支持 200 USDC。几乎没什么用。

双币投资(Dual Investment)的策略整体看下来,关键在于你心里要有一个预期的价位。比如 BTC 到 60000 就愿意买入,无论它以后会不会继续跌,都以 60000 的价格买入(卖出同理)。

双币投资更像是期货交割的逻辑,对于普通散户来说,似乎没什么用。为什么双币投资的利息高呢?因为风险也高,有卖飞或者接刀子的风险。风险高,利息就高了。

如果双币投资设定一个非常离谱的价格呢,比如在 100000 的时候买入 BTC,岂不是可以达不到条件一直赚利息了?可是利息是由风险决定的,市场看到风险小,也就没有人愿意付利息。

别作死。

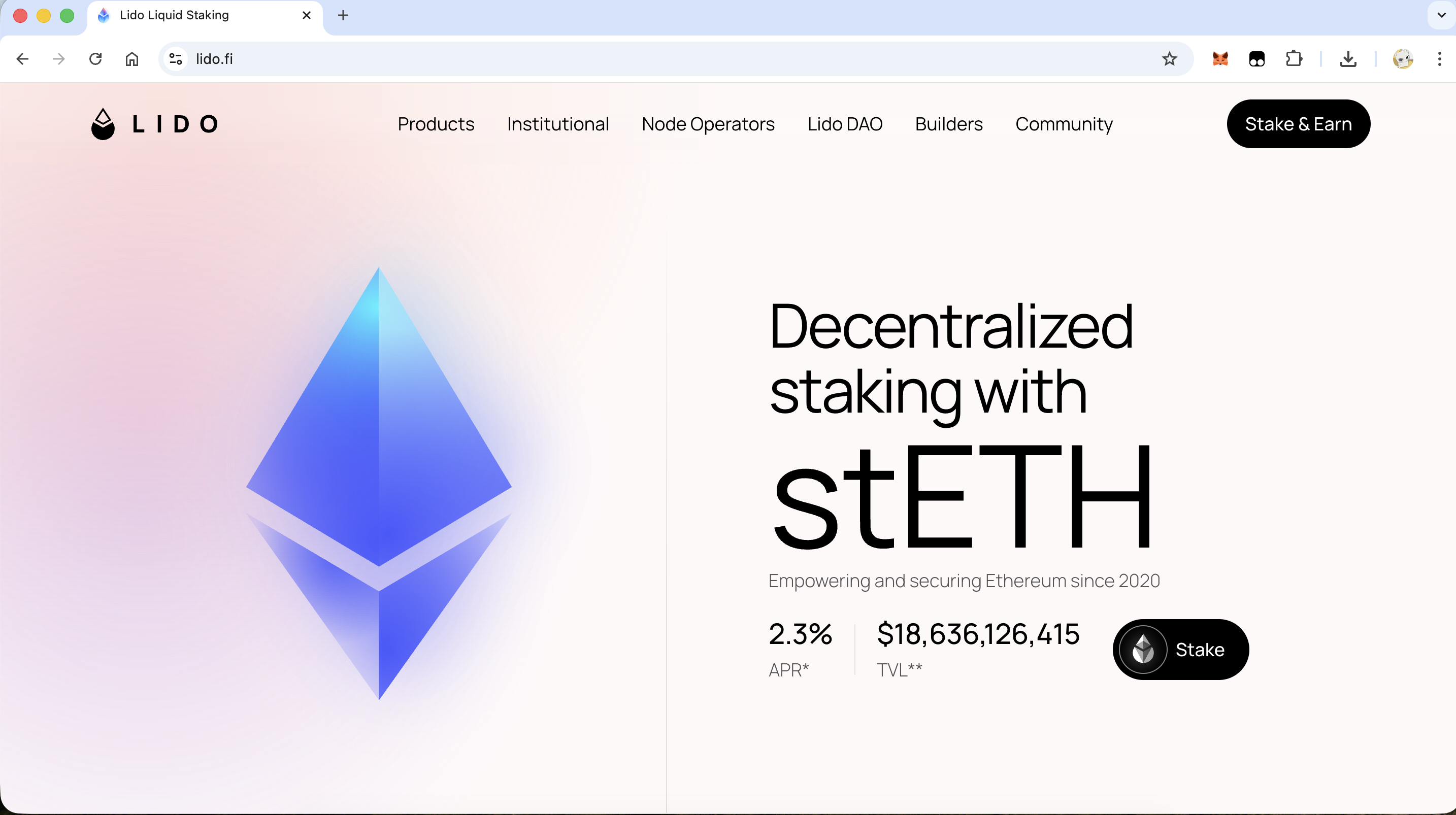

这 2.3% 的 APR 实在是太低了。用某个人的话来说,对于普通人,低于 5% 的 APR 根本不需要考虑,得至少 20 年才能赚钱。

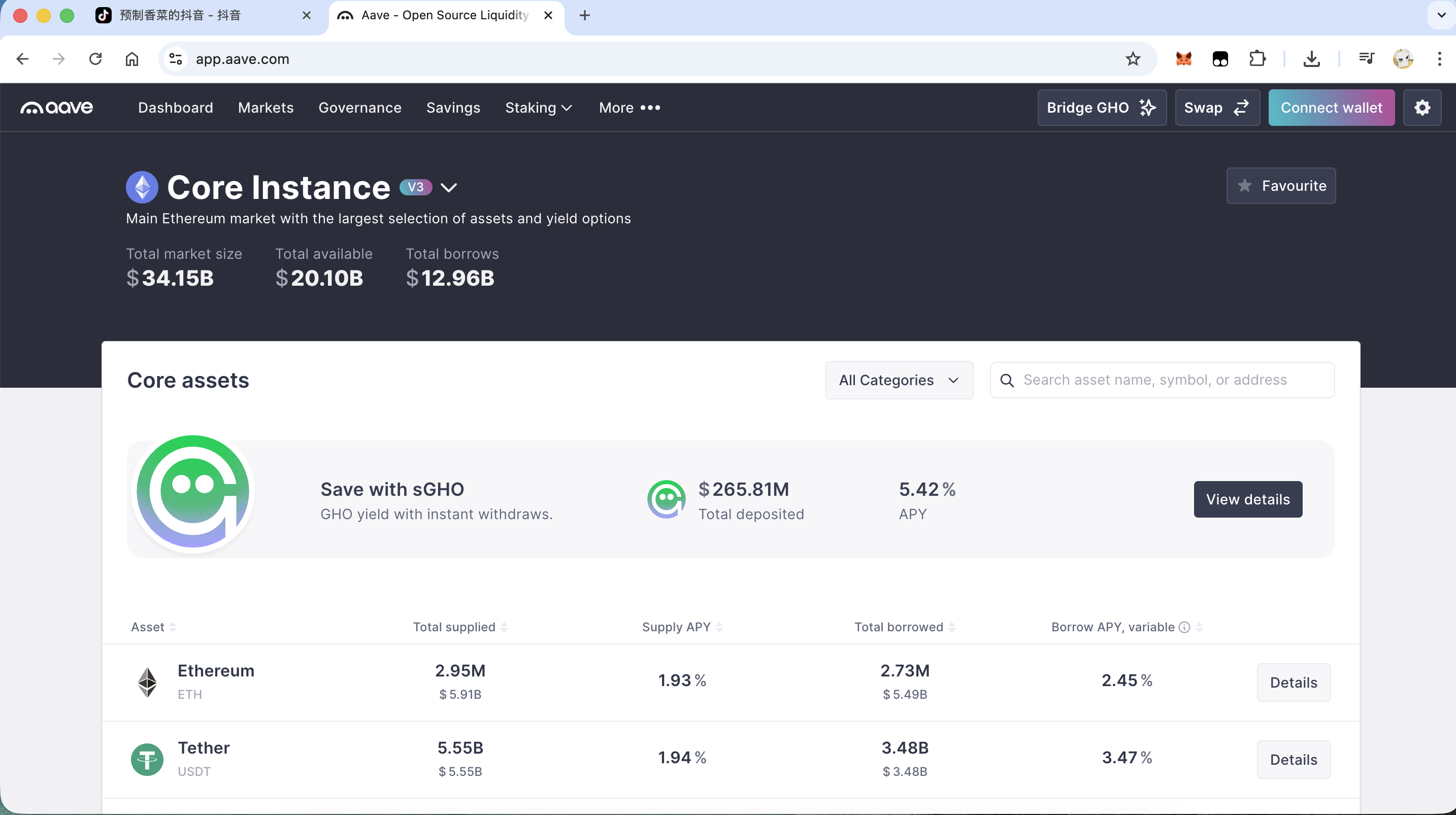

Aave 的 APR 也很低,甚至最高也低于 2%,几乎等于没有。

乍一看还挺吓人的,76% 的 APR。关键在于提供流动性是存在无常损失的,你投入 1000 ETH 和 1000 USDC,随着池子中不断进行交易,最终你提出来可能就剩 300 ETH 和 1700 USDC。代币的总量不变,但是 ETH 的价格在剧烈波动,你的投入就完全不划算了。而 Uniswap 上 USDT/USDC 这种池子的收益率在 1% 左右。

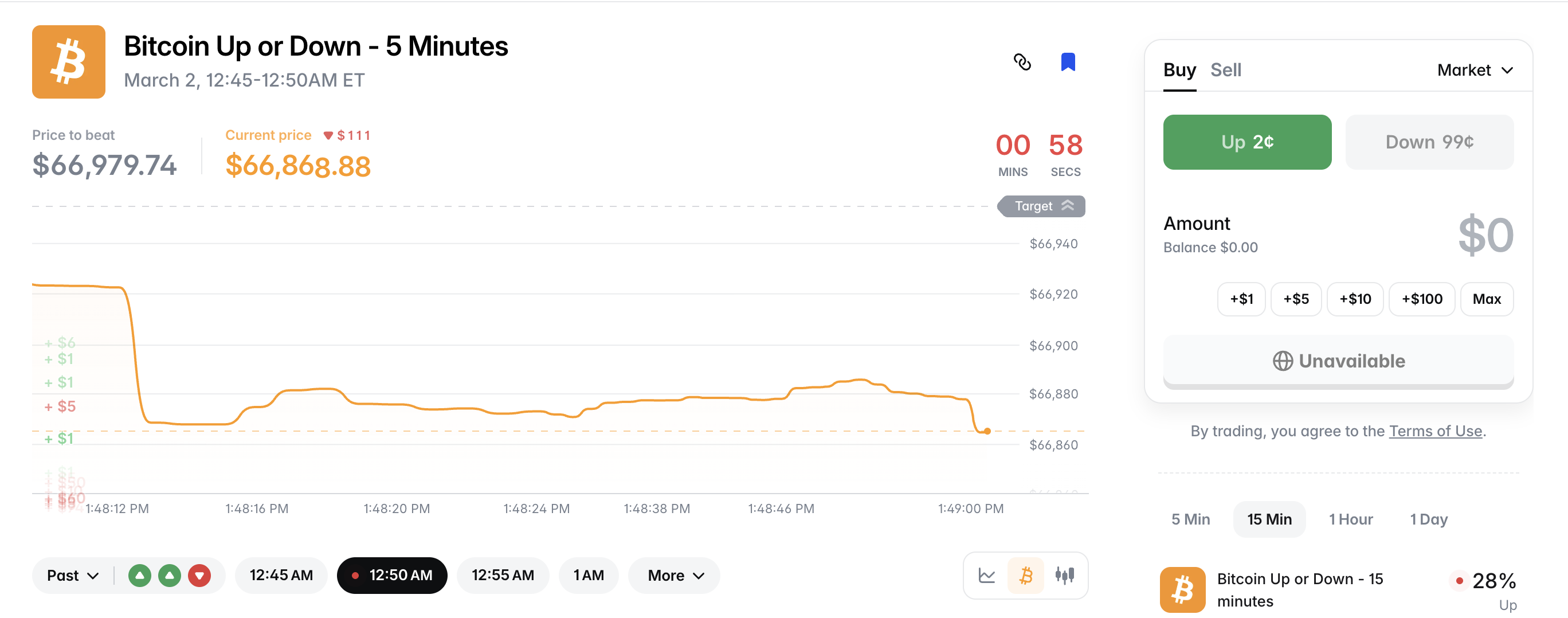

Polymarket 上线了 BTC 5 分钟猜涨跌的玩法。那么在这种市场有获利的机会吗?结论是没有。这是一种负期望值的游戏,散户、低频等同于纯粹的赌博。甚至可以认为所有的事件预测市场都是赌博。暂时别提什么稳定套利的机会了。

快省省吧。

经过这么多年的发展以及几年前的 DeFi Summer,无论是 Cex 利息还是 DeFi,随着 ETF 的推出、华尔街巨头的介入,只要市场上有低风险的套利机会,就会有几亿的资金以及高频低延迟的机器人入场。普通玩家的机会非常少。

在金融市场里怎么赚钱?

除此之外,别无他法。

散户之所以是韭菜,是因为:

反正什么都没有。有的只有无知,和赚钱的欲望。

李笑来经历过那么多项目,最后总结出的终极交易策略是定投。《定投改变命运》这本书其实写的非常好,信息密度很高。当我们对于某些高频交易策略动心的时候,不妨回顾一下这本书里提到的要点,而定投正是需要极度耐心的一种策略。

当然定投策略以及李笑来的理论,也有让人觉得扯淡的地方。比如书里到最后,给大家的建议是提高 “场外赚钱的能力”。这基本上是非常正确的废话,谁不知道场外赚钱重要……

定投是一种与人性做对抗的策略,确实很难严格落实,尤其是对于从业者来说,天天会看到行情和市场情绪,不可能做到情绪高的时候还定投,也做不到情绪低的时候管得住手。

想要赚钱,还是得做出点别人做不到的事情才行。

2026-02-12 22:16:07

2月10日,LayerZero 公布了 Layer 1 网络 Zero 的技术方案。有意思的指标有两个:

没错,号称每秒钟处理高达 200 万笔交易,是并行 EVM 链 Monad 的 200 倍,是 Solana 的 30 倍,是以太坊主网的 10 万倍,是比特币的 20 万倍。

LayerZero 的魔法在于优化了 Jolt,一个基于 RISC-V 指令集的 zkEVM,而且运行在 GPU 集群上,生成 ZK 证明的速度非常快。也就是说,当用户把大量交易提交给 Zero 网络的 Block Producers 之后,基于 GPU 集群的算力, Zero 网络可以非常快生成区块数据的证明。

Zero 网络出块的硬件要求大概是 96 核 GPU,768 GB RAM,这显然是算力中心级别的要求。那么整个网络岂不是非常中心化、被控制在少数华尔街头部公司的手里了?

由于 ZK 技术的特性,Zero 网络提供了另一个特性:验证 ZK 证明只需要非常轻量级的设备,家用电脑就可以完成对区块数据的验证。

这是一个有意思的点,为了提高 TPS,Zero 网络把出块的权力中心化,同时把验证区块的权力极度去中心化。那么 Zero 网络到底是中心化的,还是去中心化的?

去中心化网络唯一的标杆是比特币网络。虽然比特币在协议上是去中心化的,所有节点都是全节点,但事实上出块的算力基本被几大矿池垄断,比特币网络还算是去中心化的吗?

如果单从这个出块权力的集中程度分析,还真是有点难分伯仲,这也是 Zero 网络的诞生让人迷惑的点。

我们信任比特币的去中心化,是因为每一个节点都有全量账本数据,由于区块链逐个区块哈希的设计,我们可以重放所有交易历史,以此判断新产生的区块数据是否合法。PoW 共识则是所谓一 CPU 一票,哈希碰撞难但是验算简单,以此来验证出块权。所以总体来说,对于比特币,我们相信的是加密算法。

而对于 Zero 网络,其实我们相信的也是 ZK 加密算法。我们应该相信 Block Producers 会按照电路来生成证明,然后所有的成千上万的 Verifer 都可以去验证区块数据是否合法,这整个过程也完全是加密算法来保障的。

如果说 Zero 的源代码分发也许会有风险,比如生成 ZK 证明的电路逻辑出现 bug,或者验证 ZK 证明的逻辑有漏洞,给攻击者可乘之机。那么所有的区块链都面临源代码不安全的风险,包括比特币,你并不能保障比特币的源码就是绝对安全的。所以从这个角度无法区分 Zero 网络的优劣。

回到去中心化的角度,比特币网络交易重放可以保障区块数据可靠,而 Zero 网络虽然出块权被少数节点掌握,但是验证区块的权力借助 ZK 技术,能够轻易下放到任何轻量级设备上,这是比特币都无法比拟的 “去中心化”。假如 Zero 网络的 Block Producers 作恶,所有用户都可以知道,并且反馈给结算层,如果众多 Verifier 不同意,Block Producers 的出块权会被取消……

从这几个角度去对比,是不是恍惚间发现 Zero 网络竟然可以和比特币同台竞技,甚至 ZK 技术的出现给了 Zero 超越比特币的可能性?

当然,刚才刻意弱化了核心问题所在。面对这种区块链架构上的疑惑,如果一时间没有思路,可以回到区块链技术的圣经 —— 比特币白皮书 找灵感。

比特币白皮书在摘要里就提到了比特币要解决的核心问题:双花(double-spending)。

Zero 网络引入 ZK 技术确实解决了区块链数据不可篡改这个问题,但是如何解决双花问题?答案是 Zero 网络用了 PoS 共识,引入了 Validator 的概念。别管他到底是哪种 PoS,反正都是 PoS。

参考以太坊的架构去理解,以太坊有两层,执行层和共识层,执行层负责执行交易,共识层负责验证节点出块的权力。

Zero 网络的架构和以太坊有点类似,分为出块层和结算层,出块层就是用大规模 GPU 执行区块和产生 ZK 证明的那一层,而结算层,则是 PoS 质押、验证节点是否有出块权力的一层。

你也许没跟上,不是说解决双花问题吗,怎么又在讨论节点出块权力的问题了。因为假如节点出块的权力被控制,或者可以做恶,那么恶意节点就可以允许区块数据,也就是交易历史被改写,上一秒看到交易成功了,下一秒发现交易回滚了。所以节点出块的权力得到保障,双花问题也可以得到解决。

那么这下就清晰了,Zero 引入了 ZK 技术把 TPS 提高了两个数量级,确实有很大的进步。但是在共识方面,依然用了 PoS。对于一些比特币的原宗旨教徒来说,PoS 共识甚至都是不入流、不能抗审查的。那么 ZK 再牛自然也就没有意义了。

所以,Zero 网络从一开始的竞争对手就不是比特币,根本不会动摇比特币的地位。回到 Zero 网络的 Manifesto。从标题 “Multi-Core World Computer” 就能看出是奔着以太坊去的,在 Manifesto 中也直接对比了以太坊、Solana 的性能问题。当然是不可能出现比特币的。

而实际上,Zero 网络连以太坊主网的地位都不会动摇,以太坊的去中心化程度是仅次于比特币的,全节点运行在民用级设备一直是 Vitalik 的愿景 —— “如果基金会不在了,以太坊还会存在吗?”

更进一步,Zero 网络连 Solana 的地位也不会动摇,因为 Solana 独特的生态,和一些名人以及政治叙事,轻易不会被取代。

总的来说,Zero 网络仅仅只能在 EVM 的生态里做竞争,可能会直接动摇发布不久的并行 EVM 网络 Monad 的前景。其他的更大的野心,明显还做不到。

2026-02-03 15:19:01

大概是两年前的事情了。在工作中,我们用以太坊节点搭建了一条网络,上线后发现网络中不能新增 Validator,也就是质押者的 32 ETH 没有生效。

原因是我们用了多种共识层客户端,包括 Prysm 和 Lighthouse 等。为什么会突然出问题呢?因为 Prysm 有一个叫 --contract-deployment-block 的命令行参数,其他客户端比如 Lighthouse 和 Teku,这个参数的默认值都是 0(参数名字在不同客户端可能不同,但是含义类似),而 Prysm 的这个参数默认值是 11184524,这个数字是以太坊从 PoW 转向 PoS 后质押机制开始生效的区块高度。

这个参数在干什么呢?它会从这个参数配置的区块高度开始,去扫描 Deposit Contract(主网是 0x00000000219ab540356cbb839cbe05303d7705fa )上质押者的存款记录。我们平时说的质押 32 ETH,就是质押到这个合约里了,或者说就是把 32 ETH 转账给这个合约。这个合约在收到你的 ETH 之后,Consensus Client 比如 Prysm,就能根据合约的记录知道某一个地址确实给合约转了 32 ETH,因此认可这个人成为出块节点。

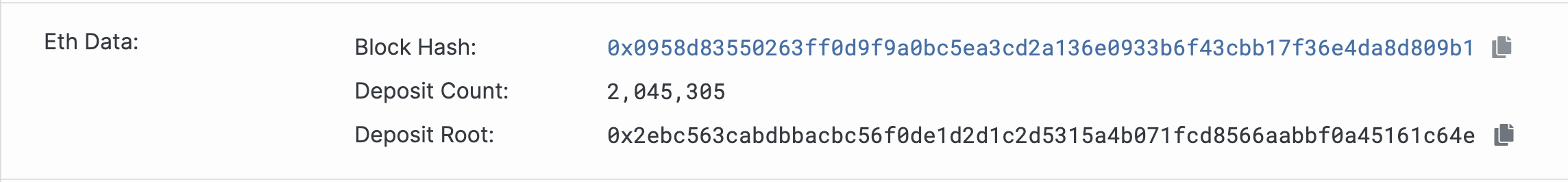

以太坊整个网络可能有几千个节点,每一个节点都在执行同样的操作,就是从 Deposit Contract 上扫描质押者列表、然后维护到自己本地的数据库状态中。直到轮到自己出块的时候,就把这个一直在维护的质押者列表的数据,计算一个总数 Deposit Count 和哈希根 Deposit Root,作为 eth1_data 字段的值,提交到区块数据中:

这个截图来自以太坊主网的区块 24374562,意味着当前以太坊一共有 204 万个质押者。要注意质押者不等于物理服务器上运行的节点数量,一个节点可以运行几千个质押者(Staker / Validator),所以推测以太坊实际上的物理节点数量大概在几千个左右。

回到 Prysm 配置的问题,如果不配置 --contract-deployment-block 参数,默认值是 11184524,那么对于一条新启动的链来说(Chain ID 不是 1 那种),Prysm 就不去扫描 Deposit Contract 合约在块高度 11184524 之前的质押记录了,本地数据库里没有质押者的数据,在出块的时候自然也不会带上 eth1_data 的字段数据。

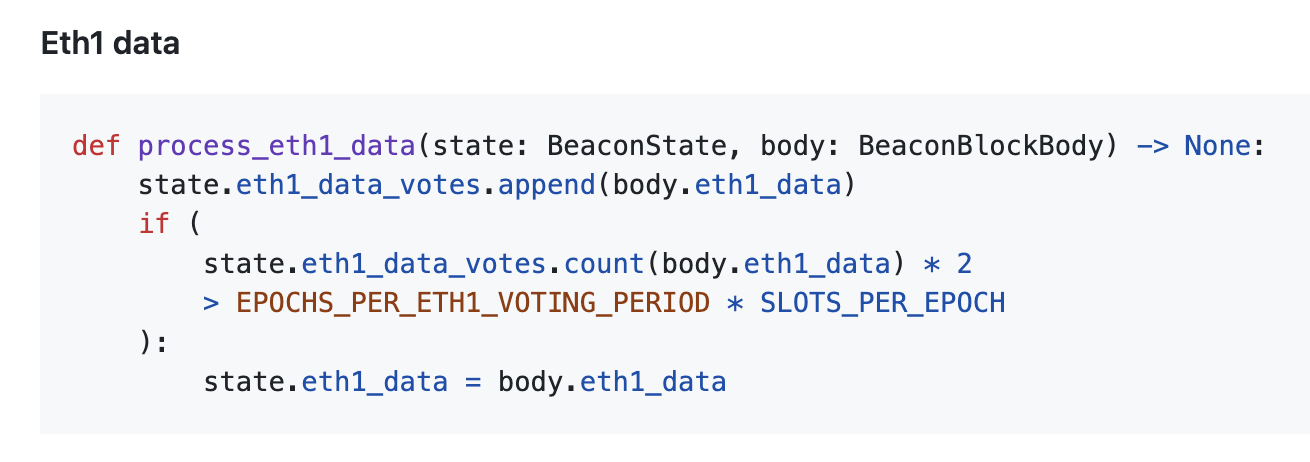

以太坊的 协议设计 中要求,eth1_data 的数据必须要超过半数节点一致才可以生效。(注意这里的比例是 1/2,和其他地方用到的魔法比例 2/3 不一样)。

所以如果你新启动的网络中有超过一半的节点用了 Prysm,同时这些 Prysm 节点没有可以设置 --contract-deployment-block 参数,网络就会异常、不能正确处理新加入的质押节点。

我们一般认为软件的默认参数是相对安全可靠的,如果刻意设置才表示我们有特殊需求。而在以太坊 Prysm 客户端的这种语境下,不刻意设置默认值反而是危险的。

2026-01-25 16:04:40

加密货币的资金管理,从最安全到最不安全的方式排名是:

如果你不在乔布斯排行榜上,家族信托就跟你没关系。对于个人而言,硬件钱包是目前最安全的方案。

这里没有提多签钱包、助记词+Passphrase 之类的方案,因为那些方案在技术手段上复杂到你都用不明白,复杂的方案是无法长期留存的,反而会增加遗忘的风险,更不可靠。

那么有几个需要更正的对于硬件钱包的认识:

而助记词安全也有几个有意思边界:

所以去中心化资产在给你带来控制权的同时,也要求你自己承担资产安全的风险。

2026-01-15 08:43:43