2026-02-09 20:36:23

谈起父亲,我始终找不到合适的开头。也许是复杂,也许只是无措。这究竟是一种怎样的感情,我很难用三言两语说清楚。又或者,我从未真正理解过他。

——题记

小时候,我对父亲的记忆,大多停在五岁那年。此后,便是一段漫长的空白。五岁之前的父亲,是零散的、破碎的。我搜刮完所有记忆,也拼不出一幅完整的图像。只记得他很高,很瘦,喜欢让我骑在他的肩膀上,喜欢用扎人的胡渣蹭我的脸,然后被母亲数落。

父亲嗜烟,也嗜酒。记忆里的他,总是烟雾缭绕,呛得我直咳。常常天黑也不回家,直到夜深,被酒友架着送回来,满身酒气。那样的夜晚总不安稳:半夜抱着马桶呕吐,或是睡死在床上,吐得一塌糊涂。母亲常为此与他争吵,却似乎从未改变什么。几十年过去,如今的父亲戒了烟,却依旧爱喝酒,只是再也不敢喝得不省人事。

父亲是家中长子,下面还有两个妹妹、两个弟弟。从很小的时候起,他便被默认成家里的顶梁柱。少年时期,读书之余,他还要在普济圩农场里帮爷爷干活,挣工分。到了高中,父亲的成绩其实很好,但家里人口多,负担不起上大学的费用,他便放弃了高考,去采石厂拉板车,做苦力,从山上往下运石子。

即便如此,他也没有完全放弃读书。通过报纸上的广告,父亲邮购了电子电路的函授教材,自己一点点学。后来凭着这些自学的本事,进了国营水泥厂做电工,端上了那个年代人人羡慕的 “铁饭碗”。家里至今还留着父亲一九八三年的电子电路笔记,密密麻麻写满了公式和各种电路图。那些内容,我在大学时因为专业原因也学过,却未必有他理解得透。直到今天,遇到一些数字电路的问题,我仍会去问他。

父亲进了国企,收入在同龄人中算是不错的。可那时家里的弟弟妹妹们还都在读书,每个月的工资大半都要贴补家用。剩下不多的闲钱,他又拿去买书和杂志。日子一直过得紧,衣着也谈不上讲究。明明已经到了该成家的年纪,相貌也算周正,却因为家境清贫,提起婚事总是难有下文。这样一拖,便到了二十七岁。在那个年代,这已算得上晚婚。二十七岁那年,父亲遇见了同样二十七岁的母亲,开启了人生的新篇章。

父亲二十八岁那年,我出生了。有了自己的小家,但大家庭的牵连并没有因此减轻。长兄如父,他依旧承担着许多责任。那几年,父亲几乎总是起早摸黑。除了厂里的工作,还张罗着小店,外出进货,零零碎碎地做些买卖。挣来的钱,连同大半的工资,仍旧贴进了大家庭里。小家的日子算不上宽裕,却也在慢慢好转。

我三岁那年,家里的光景已经比从前好了许多:客厅里有了 17 寸的康佳彩电、小天鹅洗衣机、海尔电冰箱。四岁时,厂里出资盖的房子封顶,我们也从低矮的平房搬进了六楼的新居,屋子明亮宽敞了许多。

变化始于我五岁那个新年。四叔因肝炎去世,留下了数额不小的医药债务。几乎在同一时间,父亲也查出感染乙肝,需要长期治疗。家里的经济一下子紧绷起来。那时父亲的工作虽然稳定,却谈不上高薪。厂里的福利不少,但现金收入有限,难以支撑接连而来的开销。

没过多久,父亲辞去了那份稳定的工作,南下务工,辗转于厦门、广州等地。从那以后,我很少再见到他。年关将近时,偶尔会收到他从远方寄来的邮包,里面有时是几本书,有时只是几封薄薄的家书。父亲在我记忆里的形象,也一点点淡去,仿佛只剩下这些来自远方的物件,以及相册里寥寥几张泛黄的照片。

往后七年,我的生活里没有父亲。

上小学报名时,别的孩子都是父母一起带着去的,我只有母亲。读一年级时,常能看到同学被父母接送,而我总是自己走回家。和同学打架后,别人的父亲会上门理论,我却无人出面。考试拿了全校第一,回到家,也没有人可以分享。夜里母亲上大小夜班,屋子里只剩我一个人,害怕时便缩在桌子底下。看见别的孩子被父亲牵着手,我总会不自觉多看几眼,心里却说不出是什么滋味。

二〇〇四年春节前,母亲终于决定带着我去厦门找父亲。在山沟里住了十几年的我,也第一次有机会离开那里,去看看外面的世界。山路盘旋,车子颠簸。我们从乡下出发,花了大半天才到了芜湖火车站。正值春运,母亲只买到一张零点发车的加班车车票,而且没有座位。年幼的我困得厉害,很早便在母亲怀里睡去。列车走走停停,沿着鹰厦线缓慢南下。那是一段仿佛没有尽头的路。整整四天后,我们才在除夕前夕抵达厦门。此后的几天里,耳边仍旧残留着车轮反复撞击铁轨的声响。夜里躺下时,身体似乎还随着列车微微摇晃。

我终于见到了阔别七年的父亲。比起照片里的样子,他明显老了些,鬓角已有斑驳的白发。身边的人都叫他 “老盛”,仿佛那个在老家被人喊作 “小盛” 的人,已经是很久以前的事了。我站在一旁,看着他一边和母亲说话,一边埋怨路上耽搁太久,又迅速把大包小包的行李拎在手里,带着我们往车站外走。他的动作很快,像是在处理一件再寻常不过的事情。我却不知道该对他说什么,只是跟在后面,默默地看着他。

厦门的生活,对我来说像是重新开始。为了安顿我们母子,父亲忙着找房、搬家,又四处打听学校,帮我联系借读的名额。那些日子里,他似乎总在奔走。安顿下来后,他带我和母亲去了一趟鼓浪屿。岛上有人推销拍立得合影,一张要二十元,在当时并不算便宜。父亲却还是拉着我们站在镜头前,拍下了一张合影。距离上一次拍这样的全家福,已经过去八年了。

只是这样的日子并没有持续太久。三个月后,父亲接到公司的安排,要去济南长期出差,我们刚刚安顿下来的生活,再次被打断。

父亲离开后,厦门对我和母亲来说变得有些艰难。离开熟悉的故土,在陌生的城市重新生活,一切都要从头适应。那段时间,我对父亲有过不少埋怨,也在心里暗暗下过决心:将来无论如何,都不要过他那样的生活。

日子还是一天天过去。我在厦门读完了初中,又读完了高中。父亲被公司外派到各地,辗转于大连、武汉、济南等城市,常年不在家,偶尔回来,停留的时间也很短。高考结束后,我离开厦门,去了济南读书,母亲仍留在厦门工作。就在那段时间,父亲却突然辞去了工作。或许是厌倦了常年的奔波,也或许是因为爷爷去世后,家中只剩下患癌的奶奶需要照料,他回到了老家。

一家人开始了三地分居的生活。此后多年,我们依旧很少真正团聚。也不知是不是带着几分赌气,暑假我常常选择留校,寒假才去厦门和母亲过年。能见到父亲的次数屈指可数。偶尔接到他的电话,大多不是寒暄,而是一些具体的事情:要我帮他在孔网上找旧书,或是问某个电脑配件能不能在淘宝上买到。电话通常很短,说完便挂。

再后来,我大学毕业,成了北漂大军中的一员。租房、通勤、加班、出差,日子被切成一段一段。只有过年时,才偶尔回老家一趟。母亲从厦门回到老家照顾年迈的外婆,父亲在奶奶去世后,在芜湖市区找了份电工的工作。我们一家人依旧分散在各处,一年到头也见不上几面。

二〇一五年,房地产市场暗潮汹涌,房价几乎一天一个样。我在网上看到合肥售楼部大门被购房者挤塌的新闻,开始盘算手里的积蓄和公积金,准备在老家芜湖买房。回到芜湖,我又一次见到父亲。岁月已经在他的脸上留下太多痕迹,白发爬上鬓角。这位年过半百的男人,与我时隔六年后再次面对面。我打量着他,仿佛也在打量未来的自己,心里有种说不清的微妙。

那几天,父亲带着我跑遍芜湖市区的售楼部,给我介绍城市的变化,讲哪里将来会通单轨,哪里会修学校。可到了真正要交首付时,他却沉默下来。这些年外出打工攒下的积蓄,大多已经花在了奶奶的治疗上。我最终咬牙用消费贷补齐了首付。

房子买下后,生活的压力骤然加重。我开始为了涨工资频繁跳槽,为了加薪拼命加班。工作的城市从南京到杭州,再到深圳,一路辗转。像当年的他一样,我也开始在各个城市之间奔波。不知是不是受父亲影响,我也迷上了买书、看书。那些小时候从他书架上读过的书,因为拆迁遗失,在工作后又被我一一买回。它们跟着我打包、搬家,在不同城市的出租屋里落脚,又继续被装箱带走。

我忽然意识到,自己正在一点点活成当年的他。

二十七岁那年,我遇见了现在的妻子。二十八岁那年,我也步入了婚姻。为了不在孩子的成长中缺席,也为了不走上当年父亲那样四处奔波的生活,我从腾讯离职,换了一份可以居家办公的工作。后来女儿出生,我成了一名父亲。

居家的日子并没有持续太久。没过多久,我在离家不远的合肥找到了一份新的工作,开始了两城往返的生活:周一到周五在外上班,周末回家。高铁往返的路上,常常一坐就是几个小时。夜里回到出租屋,房间很安静,有时会突然想起很多年前,在外漂泊的那个人。

这些年,我和父亲之间的联系依旧不多。偶尔通电话,也还是一些具体的事情:家里电路出了点问题,燃气要充值了,电脑配件要不要换。话不长,说完就挂。我们很少真正谈起彼此的生活。只是有些时候,当我抱着熟睡的女儿,在客厅来回踱步;当我在深夜加班,算着房贷、养娃和各种开销;当我拖着行李在合肥和芜湖之间来回奔波时,会忽然想起很多年前的他,想起他在外地的工地、厂房、出租屋里,是不是也曾这样算过日子。

有些事情,大概只有在成为父亲之后,才会慢慢明白。

小时候,我总觉得父亲离我很远。后来长大后才发现,我们其实一直走在同一条路上,只是他走在前面,我走在后面。当我终于走到他当年的位置时,才看见他曾经看见的风景,也才明白,那些沉默与缺席,或许只是另一种在场。

我们都没有成为理想中的那种父亲,但我们都在努力成为更好的那一种。

2026-01-20 23:16:44

不知什么时候开始,我已经沉醉在那个世界里不能自拔,虽然我害怕,我矛盾。但我却说不出对那种快感的依恋。夜以继日的,我逃避,我也寻找,我知道,我已经和它溶为一体了。

——三毛

多年以后,我才意识到,那种无法摆脱的感觉从未离开过自己。再次无意间看到藏在柜子里的那张早已积满灰尘的高中毕业照时,记忆便悄然回到那个下午——中考成绩刚刚公布,我独自坐在电脑前,反复权衡,犹豫不决地抉择高中。

那一天和此前无数个日子并无不同。我照旧下楼,生活千篇一律,既谈不上有什么改变,也从未真正期待改变。若一定要说,那或许是我人生前二十年里最糟糕的一段时光——我站在班主任办公室门口,听见自己的名字被念到,便快步上前,拆开信封。中考分数不低,却因非本地户口,它原本应有的意义被悄然削去了大半。

回到家,我仍兴奋地把成绩告诉父母。母亲替我高兴,但那份喜悦很快被惋惜取代。她说:“我们没有厦门户口,分数够了也不能直接报考一中,只能择校。可惜家里没那么多钱,让你去一中借读。”

那一年,厦门一中刚办完百年校庆。学生们换上天蓝色的新校服,女孩子穿着好看的百褶短裙。学校组织参观时,一中的副校长站在礼堂里,对我们说:“如果你们能考进一中,你们就是新百年的第一届。”母亲的话说完,这些光亮与可能,便与我彻底无关了。

我的父母都只有高中学历,但在他们那个年代,这已经相当不错,几乎等同于今天的大学生。母亲和父亲留下了一整书架的书与笔记,我很早就翻完了诸如《数学:它的内容、方法和意义》这样的经典读物;父亲自学数字电路的手稿,也让我在尚未正式接触课程之前,把机组的内容学了七七八八。后来,母亲带着我来到厦门,与外出务工的父亲团聚,我因此比同龄人更早走出山沟沟,看见了更大的世界。

我很难说,这究竟是幸运,还是另一种形式的不幸?无论如何,我没能进入厦门最好的高中,只读了一所不上不下的学校。家庭拮据、早熟的见识,以及父母无形中施加的期待,交织在一起,构成了整个高中的焦虑来源。直到多年以后回头看,我才逐渐意识到,那股近乎偏执的内驱力,恰恰是他们留给我的一部分遗产。

我讨厌再看那张积灰的毕业照。回忆并不温柔,它更像一种缓慢而持久的压迫。父母带我见识了世界,却也赋予我焦虑、求知欲,以及近乎疯狂的动力;我一边埋怨他们没能给我厦门户口、没能支付高昂的教育成本,一边又不得不承认,正是他们,让我成为了现在的我。

若非一定要回忆,我更愿回到高考结束的那个下午。

那天下着小雨,天色阴沉。走出考场的学生们沉默地站着,彼此很少交谈。有人或许暗自高兴,有人或许已然悲哀,我分不清自己属于哪一种。整个高中,我反复告诉自己:只要高考结束,一切就都会结束,人生也会从此翻篇。可当那一刻真正到来时,我却出奇平静——没有想象中的狂喜,也没有彻底的失落,像一只飞出笼子的鸟,却在半空中忽然忘记了回家的方向。

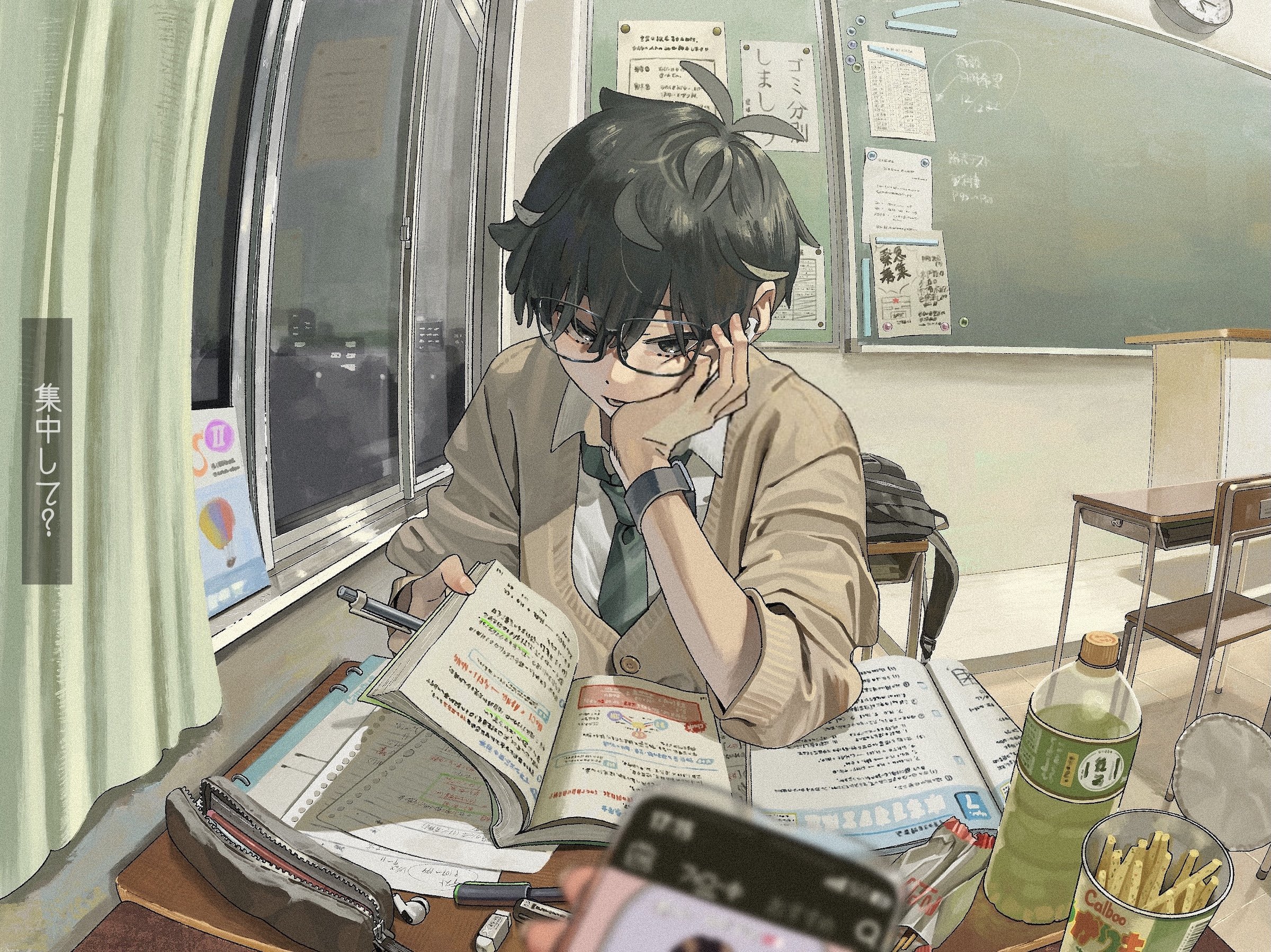

昨夜,我做了一个梦。

梦里,我回到了高中教室。书桌上堆满了书,和当年一模一样,书脊歪斜,纸张泛黄,像一堵随时会倒下的墙。我似乎在复读。几个像老师却无法辨认身份的人走过来与我说话,嘴在动,声音却像隔着水声,说了什么,醒来后已全然记不得,只剩下环境轮廓异常清晰——教室的位置、光线的角度,与现实中的高中几乎重合。

我仍坐在偏后排,靠窗的位置,那是我最熟悉、也最安全的角落,方便走神,也方便逃离。我从不爱听讲,更习惯自己翻书、做题、推演,让讲台上的声音在空气里漂浮、沉没。窗外下雨,雨水顺着玻璃滑落,一道接着一道。

梦里,雨敲在窗户上,一滴,又一滴,渐渐汇成细线,模糊了窗外,也模糊了时间。书堆积如山,陈旧纸张的气味涌入鼻腔,那是油墨,也是压力。讲台上的人影微微晃动,声音隔着一层水,听不真切,也不愿听清。有人靠近,影子覆盖下来,带着被审视、被评估的粘稠感。

我低下头,假装阅读,手指却触到冰冷玻璃,借着雨水的凉意,勉强确认自己仍存在。

为什么又回到这里?

这不是怀念。

胸口发闷,像被书压住,呼吸迟缓而费力。那也并非过去,而是一种仍在发生的状态——那些未曾结束的时间,从未真正离开我。

2026-01-06 02:35:16

今晚不知怎么地失眠了,于是把积攒了一阵子的 2025 年 10 月番,一口气追完。

以前,每当我看完一部动画、读完一本书,总会忍不住在博客里写点什么。偶尔偏激,经常肤浅,却也算留下些什么,证明那一刻并非完全空白。后来渐渐地,什么也不再记录了。现在的我,看完动画,过不了多久就已经记不起情节;日子一天天过去,回头望去,却依旧是一片浑浑噩噩。

很久以前,微信、抖音还没有这么流行,我们每天守着 QQ 和各种群聊。那里有期待的提示音,有想要回应的人。大多数人都有大号、小号,甚至情侣号,在不同的身份里,小心翼翼地安放着各自的秘密。

很久以前,有一段时间我们矫情到不肯直接在 QQ 聊天,而是跑去对方的博客留言。明明是可以即时抵达的回应,却偏要绕一圈写在博客里,只因为那样,能多一次被看见的理由。

很久以前,我们会花心思买各种主题来装扮博客,反复调整页面布局,挑选好听的背景音乐。甚至有那么一阵子,还热衷于在博客里写一些非主流的、略带伤感的文字,仿佛那样才能显得自己足够用力地活着。

很久以前,我们刷博客动态,就像如今刷朋友圈、刷微博一样。看完一家,还会顺着评论点进另一家,即使彼此并不相识,也能消磨掉一个又一个夜晚,八卦得心安理得,停不下来。

很久以前,我们一有不爽就会发日志,等着评论里的安慰,或是一场集体吐槽。然后在某个情绪更低落的夜里,又突然把它们全部删除,仿佛删掉文字,就能一并抹去当时的心情。而现在,大家似乎都学会了隐藏情绪,把这种克制称作“变得稳重”。

很久以后的现在,或许已经没几个人还在使用博客这个“古董”。今晚闲着无事,随意逛了几个朋友的博客,忽然想起年轻时竟还有这么多值得回忆的片段。也在这一刻才意识到——那些静静躺在页面里的文字,早已承载了我大部分的青春。

2025-12-31 22:22:49

不要总是一次次地追问,幸福在哪里。

其实它有时离你很近,有时却又远得不可及。

不要以为,只有恋人之间才有幸福的感觉,

其实,幸福的含义是广泛而深远的。

小时候,妈妈摇动的蒲扇是幸福;

平日里,能听到妈妈的声音是幸福;

有朋友的关心也是幸福,有父母的疼爱是幸福……

幸福不一定存在于那些特别的时刻,它往往就藏在平凡的生活中。

富有的人不一定是幸福的,

贫穷的人也不一定是悲伤的;

只要你快乐、充实地度过每一天,

内心的声音会告诉你:“我很幸福”。

不要在意幸福的形状,它如同云朵般飘逸,

变幻莫测,不可捉摸;但它从未远离过。

如果你看不到幸福,也许它只是被天空藏了起来。

没有人能够永远看见幸福的云朵,

因为每个人的生命中,都不会永远有晴天。

不要总是急于向前追逐幸福,

也许它正悄悄地跟在你身后,等待你转身。

只有认真地经历每一天,每一个时刻,

你才会发现,幸福的影子已经悄悄溶进了你的生活。

幸福是什么味道呢?

是棉花糖的甜,还是晨曦中的清新?

也许,幸福只是一瞬间的事,

来不及你慢慢品味,它便消失得无影无踪。

但那些幸福的瞬间,值得我们去回忆;

在回忆的过程中,

你会发现,比当时的事情本身,更加深刻的快乐与价值。

于是,幸福的瞬间,便变成了永恒的画面。

幸福总爱和人捉迷藏,

它总是在你寻遍了每个角落时悄然消失,

然后,又在你放弃的时候,突然回到你的身边,

让你重新拾起希望。

每个人都值得拥有幸福,如果你此刻感到不幸,

请相信,

幸福的摩天轮终将会转到你身上。

只要你有耐心,幸福最终会抵达你心里最柔软的地方。

2025-12-29 20:12:42

最近在 B 站刷到一位北京语文老师抨击上海古籍出版社《西厢记》存在数百处错误的视频。随后,又陆续看到多位 UP 主针对上海古籍出版社某些书籍中的个别差错进行“逐条批评”的内容。对此,我的看法是:大可不必如此上纲上线。

如果将视角稍稍拉远,就会发现,当下的出版业基本已可视为一个夕阳产业。在出版社内部,图书编辑长期被视为成本部门,对其工作的核心要求往往只有一条:只要符合质量标准即可。

而目前通行的图书质量检验标准是:整本书的差错率需控制在万分之一以下。只要达到这一标准,图书便被认定为质量合格,可以正常出版发行。该标准主要涵盖三类问题:其一,也是最重要的,是意识形态问题;其二,是错别字、病句、标点符号等文字层面的差错;其三,是知识性与逻辑性方面的错误。不同类型的问题有不同的统计与容忍尺度,其中意识形态问题属于红线,不允许出现。如果出现有关意识形态的问题,轻则召唤销毁全部已售图书,重则不再下发新书号。

换言之,一本书在出版后仍然存在一定数量的错误,在制度层面事实上是被默认、被容忍的。较为负责任的出版社,通常会采用“三审三校”的流程,并配有专门的质量管理部门进行不定期随机图书抽检,以期尽可能降低出版物中的差错率。但也有不少出版社采取“以量取胜”的策略(如清华大学出版社),更看重年度出版码洋,而非单本图书的质量。

在这种背景下,为了维持持续而快速的出书节奏,在有限的编辑人员编制之下,留给编辑逐字核对的时间本就极为有限,要求其修正全部差错,几乎是不可能完成的任务。尤其是在近几年图书市场持续走低的情况下,这一问题只会进一步恶化。

如果回顾早期的出版史,在铅字排版时代,一部作品在首版首印中已经存在的错误,即便后来多次加印,往往也不会被修正,因为书版一旦固定,改动成本极高。而在如今的电脑制版环境下,再加上“加印也需重新呈缴”的制度背景,每一次加印几乎都相当于重新制版,既有差错理论上都有机会在后续印次中得到修正。

因此,一般而言,同一书目越往后的印次,错误往往越少。

但问题在于,现实中并非所有出版社都真正落实了这一机制。不少出版社的质量管理部门形同虚设,只重视发行部门的业绩,对编辑部门的工作状态与修订反馈并不关心。结果是,即便读者将差错反馈给具体编辑,这些问题也未必会在后续加印中得到修正。

这也是为什么在购书时,人们常常建议优先选择“大出版社”——并非因为它们从不出错,而是其质量管理体系相对完善,更有可能避免明显低劣的出版物。

遗憾的是,这一经验在古籍出版领域并不完全适用。事实上,在上海古籍出版社相关事件发酵之前,我就已经明显感受到这一领域的图书质量正在快速下滑。例如,中华书局于 2019 年出版的《梁佩兰集校注》,便因质量问题遭到大量读者批评,最终被下架处理。

更值得注意的是,中华书局近年来重印的不少古籍,仍然沿用上世纪的铅字书版,而未重新制版。这直接导致新近印次中字迹模糊、版面老化,阅读体验极差。在古籍领域,许多所谓“精校”的简体排印本,在阅读体验和文本可靠性上,反而不如直接阅读影印底本,甚至不如一些带有题跋、校勘痕迹的旧本。

即将于 2026 年 1 月 1 日施行的《中华人民共和国国家通用语言文字法》,在相关条款中明确提出:中文出版物应当符合国家通用语言文字的规范和标准。这基本限定了未来出版图书只能以《通用规范汉字表》所圈定的规范汉字进行排印。

当然,法律也为文物古迹、姓氏、书法篆刻、题词招牌,以及出版、教学、研究确有需要的情形,保留了有限使用繁体字、异体字的空间。这种看似克制的规定,恰恰反映出立法者所面对的两难处境:一方面,需要维护国家通用语言文字的统一性与规范性;另一方面,又不得不承认,在学术、历史与文化传承领域,语言文字从来不是一个可以被简单“标准化”的对象。

问题也正出在这里。法律能够规定“能不能用”,却很难解决“用得好不好”。在古籍出版中,是否使用规范汉字表外的繁体字、异体字,本质上并非技术问题,而是编辑能力、学术判断与责任意识的问题。如果编辑团队本身缺乏相应训练与时间保障,那么即便法律允许,现实中也可能被简单粗暴地“一刀切”式简化;而所谓的“规范”,最终只剩下形式上的合规,而非文本意义上的准确。

更何况,《通用规范汉字表》颁布已逾十年,但仍有大量异体字未被扶正。很多情况下,若单纯追求形式统一,反而会造成新的错谬,使古籍的理解更加困难。

从这个角度看,图书差错之所以逐渐成为一种“常态”,并不只是因为某一家出版社、某一套制度出了问题,而是因为整个出版体系正在被迫向最低成本、最低责任的方向滑落。法律可以为文字的边界划线,却无法替代专业判断;制度可以要求“符合标准”,却无法强制生成真正的敬畏与耐心。

或许,真正令人担忧的,并不是我们是否还能读到一部“零差错”的书,而是当下一代读者逐渐失去辨认、理解古籍原貌的能力时,是否还会意识到:那些被省略、被简化、被误读的地方,原本曾经承载着更为复杂、精细的思想世界。2023 年新春贺岁片《满江红》在宣发中,将“髪”误写为“發”的海报错误,或许并非孤例,而只是一个预兆。

如果说这是一种悲哀,那么它恐怕并不只属于出版业。

责任编辑工作只做到符合工作最低要求的程度是普遍现象。

在中国大陆语境下,通常特指:坚持马克思主义的指导地位和中国特色社会主义道路;反对历史虚无主义、西方“西化”思潮以及极端个人主义等资本主义思想;维护国家认同感和中国共产党领导地位。

在出版语境下,通常特指:宣传与中国共产党、中华人民共和国以及中华民族的政治目标和社会价值取向相背离的意识形态,尤其是对前苏联的“抹黑”。

三审三校:对稿件进行三次审查和三次校对。每轮审校过程为:编辑审读修改稿件,修改结果交予作者核实;作者核对通过后,编辑交予排版人员重新排版;校对人员将排版结果对比原稿,尤其是修改过的部分(核红)。

出版管理条例 第二十二条:出版单位应当按照国家有关规定向国家图书馆、中国版本图书馆和国务院出版行政主管部门免费送交样本。

社会一般应用领域的汉字使用应以《通用规范汉字表》为准,原有相关字表停止使用。

《通用规范汉字表》共收字 8105 个,一级字表为常用字集,收字 3500 个,二级字表收字 3000 个,三级字表收字 1605 个。

汉字简化中往往一简多繁,但在《通用规范字表》中,并未全部纳入。参阅《一表顶过去多表的〈通用规范汉字表〉有哪些缺陷?》。

2025-12-22 21:20:43

提到《新概念英语》,一共四册,很多人会下意识地以为:作者亚历山大是按顺序,从第一册一路写到第四册的。但如果真正去了解这套教材的成书背景,就会发现事实并非如此。某种意义上说,《新概念英语》并不是一套“循序渐进”的产物,而是一套不断向上下延展、反复修正的教学实验成果。

事情要从上世纪五十年代说起。当时,英语作为第二语言(ESL)的教学方式基本得到认可。以唱片为基础的灵格风教程(The Linguaphone English Course)便是其中同时期典型的代表,其强调模仿和听力输入。在同一时期,亚历山大也受邀为德国的英语学习者编写一套类似的英语 ESL 教材。与很多教材作者不同的是,这本书的语法核心,并不在词法,而在句法。

如果你仔细读过《新概念英语》第二册,就会发现它最鲜明的特点只有一个:反复。不是机械重复,而是有层次、有方向的 Recurring。每一节课的文章,全篇基本上对应一个语法概念,以不同的形式去表达。同一个语法结构,会在相邻的几课中不断出现,第一遍只是让你认识它,第二遍让你习惯它,第三遍开始要求你自然地使用它。

很多人会有这样的体验:第二册里,第一课和第二课好像在讲同一个东西;等到了下一个单元,又感觉内容“似曾相识”,但表达却更复杂了。其实这并不是偶然,而是作者刻意为之。每一个新单元,都会在结构上衔接前一个单元的核心句法,再向前推进一步。

第二单元到第三单元,每隔 24 课就会循环重复学习同一个语法内容,但每次都不是完全重复,而是会新增有关该语法点的新的内容。比如说,第 16 课、第 40 课、第 64 课都是有关 if 引导的条件状语从句的内容。第 16 课学习的是真实条件句的内容;第 40 课学习的是 if 引导的虚拟条件句的内容,但针对的是现在发生的事情的虚拟;第 64 课学习的也是 if 引导的虚拟条件句的内容,但针对的是过去发生的事情的虚拟。

第二册的最后一个单元,不再学习新的语法内容,而是把前面三个单元所学的内容进行了全面的总结复习。

从教学设计的角度看,这是一整套围绕句法展开的训练系统。一本书下来,几乎所有常见的英语句型和结构,都被系统性地覆盖了一遍。这也是为什么很多人后来回头看才意识到:新概念英语真正的“骨架”,就在第二册。

正因为第二册的起点偏高,在实际教学中并不算友好,亚历山大并没有顺势去写第三册,而是选择向下编写第一册,用来降低入门门槛。

第一册的思路明显不同。它不再追求句法体系的完整,而是强调可用性和口语感。整本书的结构非常清晰:奇数课讲语法和句型,偶数课做练习和巩固;内容以简短对话为主,刻意回避复杂结构。它更像是一座“缓冲区”,让学习者在进入第二册之前,先适应英语的基本表达方式。

在这个意义上,第一册并不是整个体系的起点,而是为了配合第二册而诞生的辅助教材。

第三册在编写思路上,基本延续了第二册的路线,只是将重点从简单句逐步转向复杂句。句子变长了,结构变多了,但依然保持着“一篇文章集中训练一种核心表达”的原则。

真正发生变化的是第四册。它是四册中唯一一本不完全以亚历山大原创语料为基础的教材,而是选取了当时的一些经典文章进行改编。这也使得第四册在风格上,与前三册明显不同:文学性更强,但教学针对性反而弱了一些。 因此,很多人学到第四册时,会明显感觉“味道变了”,这并不是错觉。

《新概念英语》进入中国,并不是从书店开始的。最早,它是在一些大学内部以影印教材的形式流传,用来替代当时广泛使用的《许国璋英语》。在 1992 年中国正式加入伯尔尼国际版权公约前,国内陆陆续续出现过大量不同版本的盗版《新概念英语》,它们或冠以“内部交流”的字样,无具体的出版社信息。或者是加上一些中文译注,使用统一书号进行出版。1992 年后,国内盗版的外文书籍虽然依旧存在,但大型出版社都开始同外方进行版权协商购买引进图书。此时《新概念英语》被世界图书出版公司、上海外语教育出版社和安徽科学技术出版社相继引进,其中比较有代表性的就是上海外语教育出版社的版本,同时还有原版的音频。

真正的转折点,是外研社社长李朋义先生,通过朗文出版亚洲有限公司总裁的沈维贤先生牵线搭桥,邀请到《新概念英语》的作者亚历山大来中国各地讲学,每一场演讲都座无虚席。在这期间李朋义与亚历山大建立了深厚的友谊,并以改编为前提签订版权合同。在世图等出版社的两年后版权到期后,外研社获得了《新概念英语》的独家改编版的出版权。改编期间外研社并邀请亚历山大来到北京,与何其莘教授一起对新教材进行研讨。新版增加了中文译注,前三册基本与原版一致。第四册改动较大,在原版基础上,扩展了大量的课后习题和测试。相比第四册原版的 60 篇文章,新版删去了 19 篇文章,新增了 7 篇文章。

由于这一版本同时包含何其莘的著作权,实际上也使外研社实现了对这套教材的长期、稳定控制。

此后,《新概念英语》逐渐成为外研社的王牌产品。围绕正教材,又陆续推出了导读、练习册、名师讲解等一整套配套内容。原本主要面向课堂教学的教材,也被一步步包装成可以“自学”的体系。

2007 年,裕兴为学习机配套制作的新概念教学视频,对外研社与北外合作录制的《新概念英语名师导读》造成了直接冲击。外研社随即提起诉讼,并最终胜诉。这场官司,也从侧面反映了新概念英语在市场上的商业价值。

在亚历山大去世后,版权转至其妻子朱莉名下。为了继续维持版权合作,外研社又邀请她编写了《新概念英语青少版》。需要强调的是,这与原版《新概念英语》在理念和内容上,已经是完全不同的两套教材了。

自出版以来,《新概念英语》始终是外研社的代表作,其年均销量500万册。《新概念英语》支撑起外研社的主要营收,并带动了其他图书产品的销售。毫不夸张地说,外研社的新大楼的建设资金就是靠着这本书一本一本卖出来的,现在的外研社大楼楼下还竖立着《新概念英语》作者 L. G. Alexander 先生的雕像。

《新概念英语》成书于 1967 年,以今天的眼光来看,确实存在不少过时的词汇和表达。比如第一册中出现的 typist、keyboard operator,对现在的孩子来说,几乎已经失去了现实指向。

但如果因此就否定这套教材,其实是本末倒置。新概念真正的价值,从来不在词汇更新,而在编写方法。它用人为精心设计的文章,反复强化同一个句法结构,让学习者在不知不觉中掌握语言规律。

在当下大量 ESL / EFL 教材依赖语料库生成内容的背景下,新概念第二册、第三册那些“刻意为之”的课文,依然非常能打。这种耐读、耐用的教材,在今天反而越来越少见了。

1932 年,路易斯·乔治·亚历山大出生于伦敦,母亲是澳大利亚人,父亲是希腊人。第二次世界大战期间,他与母亲在澳大利亚生活,战后回到英国,并在萨里郡的 Godalming 文法学校和伦敦大学玛丽皇后学院接受教育。

在英国陆军德国服役期间(1954—56),他有了作为教育工作者的第一次经历,作为教育兵团指导员教授 A-level 英语。之后,他开始了他的英语教学和材料写作生涯。1956 年至 1965 年,他在希腊雅典的 Lykeion 学校(现在的 Skholi Moraiti(Moraitis School))任教,大部分时间担任英语系主任。

他在 20 世纪 60 年代早期开始出版,与 Longman 合作。他的第一本书(出版于 1962 年)是《纲要的六十步》,第二本书是 1964 年出版的第一本书。《新概念英语》是他的第一本主要丛书,出版于 1967 年。随后,朗曼又推出了一系列具有开创性的系列:Look、Listen and Learn(1968—71)、Target(1972—74)、Mainline(1973—81),它们都在全球范围内取得了巨大成功。从 1968 年到 1978 年,亚历山大是德意志人民高中协会的顾问,他为德国成人教育的两大英语考试的设计做出了贡献。在 1973 年到 1978 年间,他是欧洲委员会现代语言教学委员会的成员,并与他们合著了有影响力的“交际”课程《门槛水平》(1975)和《Waystage》(1977)。他对教学大纲的兴趣在《英语语法结构》(1975)中也得到了证明,这是一个语言学习的分级结构的基本教学大纲。

1977 年,路易斯·亚历山大卖出了 470 万册书,这是吉尼斯世界纪录中个人作家一年卖出的最多的书。从 1979 年到 1980 年,他为 Follow Me(BBC 和 Longman)提供了蓝图,并撰写了课堂材料,将入门级教学大纲付诸实施。据估计,这个节目已经有 5 亿学习者观看。

从 1977 年到 1981 年,亚历山大还专注于英语以外的语言教学。20 世纪 80 年代初,他制作了最早的计算机语言学习课程之一,包括法语、西班牙语、意大利语和德语,软件由百代公司为雅达利出版。1980—83 年,他开发了《生存蓝图》,一个用多种语言自学的系列课程。1986 年至 1988 年,他担任剑桥大学国际交流英语考试委员会(UCLES)的顾问;1987 年至 1988 年,他出版了《简明英语》一书。

20 世纪 80 年代,亚历山大还将注意力转向撰写参考书:《朗曼英语语法》(1988 年;1990 年的练习本)和 1993 年的《朗曼高级语法》。

20 世纪 80 年代末,他在联合国教科文组织工作,参与了《九年义务教育三年制初级中学教科书 英语》(1988,人民教育出版社,北京)的编写,他提供了教材的技能大纲和语言大纲。当内维尔·格兰特写这门课时,亚历山大监督并建议。据估计,截止新课改前,中国每年有 4000 万学习者在使用这个系列。

1994 年出版了《直捷英语》(由交互式光盘和录像组成,并带有互联网组件),1997 年出版了专门为中国出版的《新概念英语:新概念英语(中文)新版本》。

路易斯·亚历山大于 2002 年去世。2003 年 11 月 4 日,他的铜像在北京外国语大学的外语教学与研究出版社揭幕,该出版社是中国最大的教科书出版商之一。

注:以上照片的复印件是由茱莉亚·亚历山大(Julia Alexander)发给我们的,在她的许可下分享。