2025-03-22 23:52:12

最近,一个数据查询服务被业务方反馈拿不到数据,但接口响应是成功的,不报错,仔细排查后发现数据查询库用的是 pgx,但 pgx 返回的错误未被处理,导致服务接口没有响应错误。

在后续的排查过程中,发现这其实不算是 pgx 的问题,而是 database/sql 中的坑,所有涉及用 database/sql 查询的都需要显式处理 rows.Err()。

服务所用 pgx 版本为 4.10.1。查询函数主要用的是 QueryRow(返回一条数据) 和 Query(返回多条数据),更近一步的测试中(人为制造查询错误,eg:锁表)发现,调用 QueryRow 函数的接口,如果发生查询错误的问题,服务接口会正常响应错误。深入 pgx 源码发现,QueryRow 本质是对 Query 的进一步封装,对应的 Scan 函数源码为:

1 |

// QueryRow 返回的 connRow 对应继承自 Query 返回的 connRows 对象 |

从源码中可看出 QueryRow 的 Scan 函数有一系列的错误处理,而 Query 对应的 Scan 是更底层的函数,返回的仅是 Scan 过程中的错误,其他的错误需要在业务上层处理。Close 函数同样可能会出现错误,需要调用 rows.Err() 主动检查错误(这一步至关重要)。对于 Close 报的错,可以这样处理:

1 |

var err error |

数据库执行 sql 失败的错误(eg:canceling statement due to conflict with recovery),在 Close 后才会暴露出来,所以不处理这个错误,就不会返回错误,但数据又查不到,服务接口也表现为响应成功,导致上层业务误认为数据库里还真没数据。

最好的方式还是避免每次都手动 Scan,pgx 其实还提供了更上层的函数 QueryFunc,该函数封装了大部分错误处理:

1 |

func (c *Conn) QueryFunc(ctx context.Context, sql string, args []interface{}, scans []interface{}, f func(QueryFuncRow) error) (pgconn.CommandTag, error) { |

不过 QueryFunc 函数在新版本中(5.7.2)已被 ForEachRow 替代:

1 |

func ForEachRow(rows Rows, scans []any, fn func() error) (pgconn.CommandTag, error) { |

而 ForEachRow 的使用示例可以看这个函数:

1 |

func (c *Conn) getCompositeFields(ctx context.Context, oid uint32) ([]pgtype.CompositeCodecField, error) { |

对于一个不熟悉的底层库,最好的学习方式还是看它的示例代码,库的开发者很难知道用户会踩哪些坑,文档中自然不会有,毕竟当局者迷。只从文档出发,很容易陷进未知的坑里,甚至掉坑里都不知道,业务出问题后,花费大代价排查之后,才知道掉坑里了。陌生的开源库在使用的时候还是先全库 clone 下来,用 api 的时候,就去源码里搜一下,看看开发者写的示例(不管是测试,还是其他地方的调用),当然现在也可以让 AI 先写,人只要再核实一下文档和源码,能节省很多学习的功夫。

2025-01-26 23:26:15

出去玩看风景很大程度上受天气的影响,所以一般会使用「莉景天气」和「天文通」提前看下天气预报。莉景天气对于各种气象奇观都有明确的预报概率,但需收费;天文通免费,但只能根据其上的数据自行推断,Shaun 根据网上的一些资料和个人见识总结了一些奇观的出现条件。天气数据都有个准确率的问题,尤其是在高海拔地区,气象多变,数据仅供参考,所以下面列出的条件也都仅供参考,气象奇观出现是幸运,不出现才是正常的。

2025-01-12 16:47:28

最近看到这么一个工具——ollama-ocr,利用本地大模型直接进行 OCR,试用了一下,感觉效果还不错,联想之前看到的一个项目——PDFMathTranslate,感觉本地大模型已经非常成熟了,部署使用也越来越简单了。

如果需要提供 LLM 服务,还是用 vLLM 部署相对合适。

硬件:M3 MBP,10 核 GPU(Metal 3),16G 内存

系统&软件:macOS Sonoma 14.5,Ollama 0.5.4,AnythingLLM 1.7.2;

第一次启动 Ollama 时,会出现安装「command line」的引导界面,输入电脑用户密码安装即可,安装命令行之后,可以直接点击「Finish」,之后通过终端命令 ollama 操作 Ollama,毕竟 Ollama 没有提供 UI 界面,当然也有很多三方的界面。

之后在终端中直接运行 ollama run llama3.2:3b,等待模型拉取完成后,即可直接与模型对话。之后可以在 Ollama 官网 Models 搜索尝试更多模型。

命令解析:

Mac 中修改全局环境变量可通过 launchctl setenv 命令,eg: launchctl setenv OLLAMA_ORIGINS "*",允许 ollama 请求跨域。

Mac 中 ollama 拉取的模型文件默认放在 ~/.ollama/models 目录中,可通过修改 OLLAMA_MODELS 环境变量更改模型安装目录。

Ollama 默认服务地址端口是:127.0.0.1:11434,Mac 中查看进程监听的端口号命令为 lsof -nP -p <pid>。可通过修改 OLLAMA_HOST 环境变量更改默认端口,eg:launchctl setenv OLLAMA_HOST "0.0.0.0:6006"。

默认情况下,运行模型后,如果 5 分钟未与模型进行交互,将会自动停止该模型。

Mac 启动 Ollama 后,会在菜单栏上出现一个羊驼图标,但有时这个图标会被“刘海”挡住,导致无法退出 Ollama,这时可以使用 osascript -e 'tell app "Ollama" to quit' 命令退出 Ollama。

对于开发者,若需要更改默认端口,需修改环境变量:export OLLAMA_HOST=0.0.0.0:6006(如此可将 ollama 的默认端口修改为 6006),之后通过 ollama serve 命令启动 Ollama,通过该命令启动的不会在菜单栏上出现羊驼图标。若出现跨域问题,同样需要修改环境变量:export OLLAMA_ORIGINS="*"。

AnythingLLM 有两种安装模式,一种是桌面版,一种是 Docker 版,桌面版只能本地使用,Docker 版相当于是服务版,支持多用户云端使用。本次选用的桌面版,基本的 RAG 功能也都有。Docker vs Desktop Version

第一次启动 AnythingLLM 时,有一些设置引导,设置「LLM 偏好」时选择 Ollama,其他的都默认即可。创建工作空间之后就可以上传本地文件,建立自己的知识库。

Shaun 在使用中感觉,AnythingLLM 响应还是比较慢,分析/提炼/归纳/总结本地文档的速度有限。可能是机器配置还是有点低了。

命令行使用:

1 |

用 ollama 将本地文件 Black Hat Rust.pdf 从英文翻译为中文 |

出现 NotOpenSSLWarning: urllib3 v2 only supports OpenSSL 1.1.1+, currently the 'ssl' module is compiled with 'LibreSSL 2.8.3' 警告时可忽略,不影响使用。

如果出现 huggingface_hub.errors.LocalEntryNotFoundError 错误,需要配置 hugging_face 国内镜像:

1 |

pip3 install -U huggingface_hub hf_transfer -i https://pypi.tuna.tsinghua.edu.cn/simple |

同时下载模型到本地(需要具体看报错的是哪个模型,这里是wybxc/DocLayout-YOLO-DocStructBench-onnx):

1 |

huggingface-cli download --resume-download wybxc/DocLayout-YOLO-DocStructBench-onnx --local-dir . |

选择本地ollama模型作为翻译服务的话,需要配置环境变量:

1 |

本地ollama服务地址 |

有个浏览器插件「沉浸式翻译 - Immersive Translate」同样是个比较好用的翻译工具。不过对于 PDF 文件,都有可能出现译文重叠的现象,需要二次编辑一下,或者将 PDF 格式转换为其他格式(eg:html,epub 等,相关 issue)。

Continue 插件可结合本地的 ollama 使用 qwen2.5-coder:7b 模型,可辅助读/写代码,需打开以下设置:

模型设置添加:

1 |

{ |

自动补全设置中 apiKey 保持为空字符串就行。

若需要使用远程部署的 ollama 服务,可以新增参数 "apiBase": "http://<my endpoint>:11434"。

Cline 插件同样可结合本地的 ollama 使用,可辅助 CR 以及自动化优化修改代码。如果使用 vLLM 部署的 AI 服务,API Provider 选择 OpenAI Compatible,Bsae URL 填 http://ip:port/v1,API Key 随便填就行(eg: ollama),Model ID 则是模型名称(eg: deepseek-r1:14b)。

20250207 更新:

本地部署 LLM 的好处在于无数据泄漏问题,对于个人使用而言,轻量级的模型也差不多够用了,但即使已经轻量化了,本地运行大模型还是有点吃力,在 Shaun 的电脑上运行 phi4:14b 略显勉强(8 tok/s)。Mac 的内存和显存是共享的,后续如果买新的,有部署 LLM 的需求,最好把内存拉满,由于模型文件也相对较大,有条件的可以把 SSD 也拉满。希望后续大模型的推理能够进一步轻量化,效果也更好,真正实现人人都能使用。

自 GPT-3 出现以来,也就短短 4 年不到,从大规模的高性能 GPU 集群到单机部署,从胡言乱语到精准命中,各行各业都迎来了 LLM 的冲击,在可预见的未来,LLM 将深刻影响到每一个人,这种影响无关好坏,单纯只是时代的浪潮,LLM 将和操作系统,数据库一样,成为整个 IT 行业的基础设施,就 Shaun 而言,应该很难亲自动手去开发优化 LLM,能做的也就是尽可能的熟练使用。

20260121更新:

2024-12-22 22:26:19

工作中偶尔会遇到一些特殊需求需要解决,这里记录一下。

使用 setfile 命令:

修改创建日期:

setfile -d "mm/dd/yy hh:mm:ss" filename修改修改日期:

setfile -m "mm/dd/yy hh:mm:ss" filename同时修改 xxx.txt 文件两个时间为 2023-07-27 01:23:53:

setfile -d "07/27/2023 01:23:53" -m "07/27/2023 01:23:53" ./xxx.txt

word 和 excel 本质上都是 zip 文件,可利用 openpyxl 修改 xlsx 文件元信息创建时间。对于 xls 文件,若文件有密码,需先去除密码,再将 xls 转换为 xlsx 文件,之后使用 openpyxl 修改时间。具体步骤如下:

用 AppleScript 将 xls 转换为 xlsx

1 |

def run_applescript(script): |

修改 xlsx 文件创建时间

1 |

import openpyxl |

将 xlsx 转换为 xls 文件

1 |

def xlsx_to_xls(file_path="./xxx_tmp.xlsx"): |

利用 pillow 和 piexif 修改 jpg 文件 exif 信息时间

1 |

from PIL import Image |

Pillow 保存 jpg 图片默认会同时保存 JFIF 和 EXIF 头,若需要去掉 JFIF 头,需修改 Pillow JpegEncode.c 文件源码:

1 |

if (context->xdpi > 0 && context->ydpi > 0) { |

修改为:

1 |

context->cinfo.write_JFIF_header = FALSE; |

之后执行:python3 -m pip -v install . 从本地源码安装 Pillow。

使用 pikepdf 修改 pdf 文件元信息时间

1 |

import pikepdf |

2024-05-12 10:26:32

最近业务调用方反馈接收到服务连接中断的错误(python requests 请求抛出异常 raise ConnectionError(err, request=request) \n ConnectionError: ('Connection aborted.', BadStatusLine("''",))),但从 golang 服务日志中看,服务应该是正常处理完成并返回了,且抛出异常的时间也基本和服务返回数据的时间一致,即表明在服务响应返回数据的那一刻,请求方同时抛出异常。

这个问题很奇怪,起初拿到一个 case 还无法稳定复现,最初怀疑是网络抖动问题,但后续一直会偶发性出现,直到拿到了一个能稳定复现的 case,深入跟踪排查后才发现与网络问题无关,是服务端框架应用设置不合理的问题。

从网上搜索 python ConnectionError: ('Connection aborted.'),错误种类非常多,有网络问题,服务端问题(关闭连接,拒绝服务,响应错误等),客户端关闭连接,超时设置不合理,请求参数/协议错误等等,但若带上 BadStatusLine("''",) ,错误就相对比较明确了(BadStatusLine Error in using Python, Requests,Python Requests getting ('Connection aborted.', BadStatusLine("''",)) error),主要是由于收到了一个空响应(header/body),空响应可以明确是服务端返回的问题,一般可能有以下几个原因:1. 服务端反爬;2. 服务端超时(比如 nginx 默认 60s 超时);3. 网络错误。

由于是内部服务,所以反爬策略是没有的,而反馈的 case 都带有明显的特征(请求数据量大,处理耗时长),没有网络抖动那种随机性,所以应该也不是网络问题,剩下的只能是超时问题,由于业务方在前置策略上已经识别该 case 数据量大,所以不经过 nginx 网关,直连服务请求,所以也不会有 nginx 超时问题,只能是服务端自己超时。于是直接在代码中查找 timeout 关键字,发现在服务启动时设置了 ReadTimeout 和 WriteTimeout,进一步深挖之后,才对 go 服务的超时有了浅显的认识。

参考资料:1. 你真的了解 timeout 吗?,2. i/o timeout , 希望你不要踩到这个net/http包的坑,3. net/http完全超时手册。

由于 HTTP 协议规范并未提及超时标准,而为保证服务稳定性,一般的 HTTP 服务请求都会设置超时时间,各 HTTP 服务端/客户端对于超时的理解大同小异,而这次的问题又起源与 go 服务,所以以 go 为例,分析一下超时。

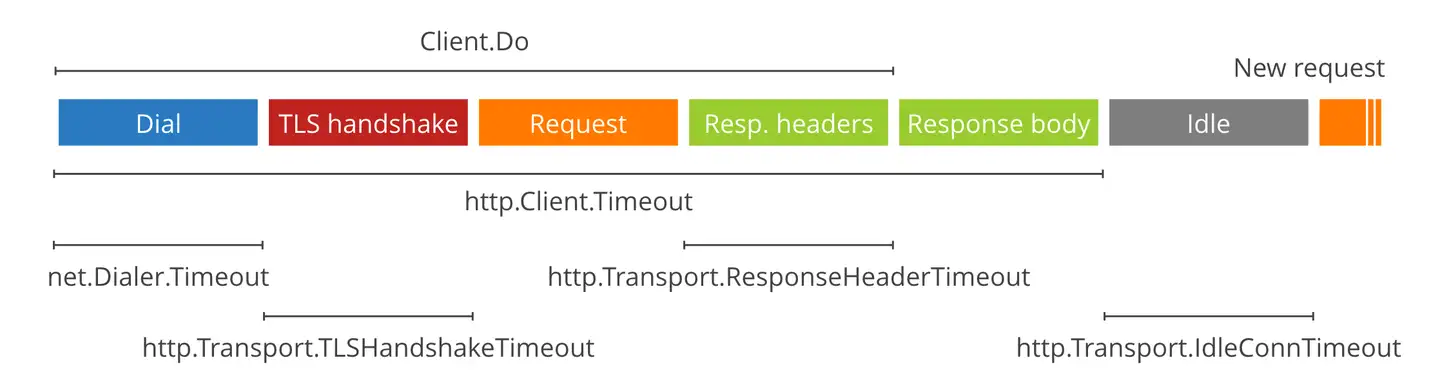

客户端超时,即 GET/POST 请求超时,这个很好理解,就是客户端发送请求到客户端接收到服务器返回数据的时间,算是开发的一般性常识,控制参数一般也特别简单,就是一个 timeout,当然 go 服务客户端支持设置更精细化的超时时间,一般也没啥必要。当客户端感知到超时时,会正常发起 TCP 断开连接的“四次挥手”过程。

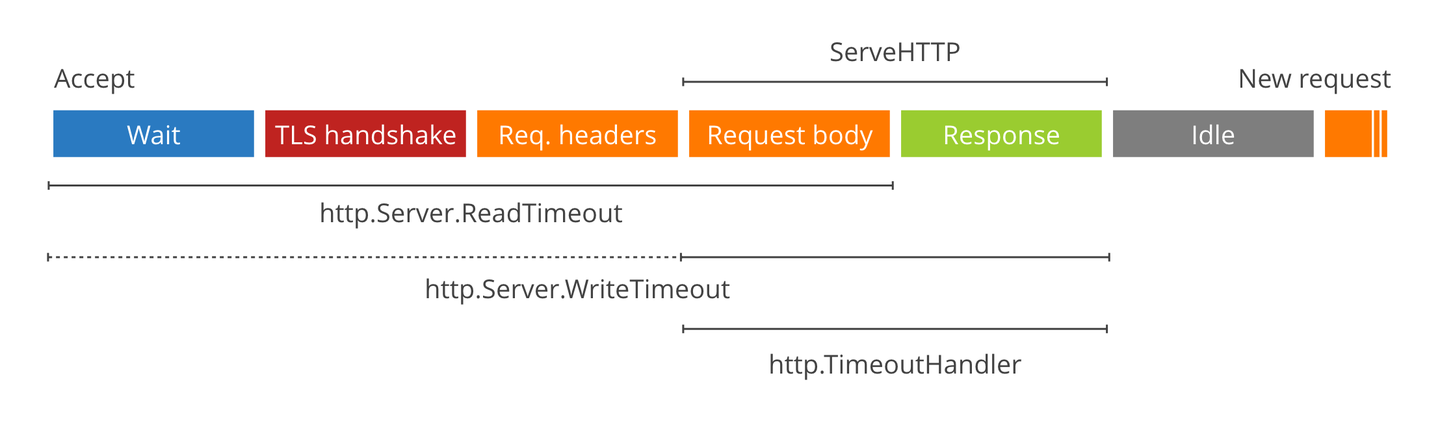

服务端超时,这才是引发问题的根本原因,go 服务端的超时,主要有两个参数,ReadTimeout 和 WriteTimeout,从上图可以看出,ReadTimeout 主要是设置服务端接收请求到读取客户端请求数据的时间(读请求的时间),WriteTimeout 是服务端处理请求数据以及返回数据的时间(写响应的时间)。GoFrame 框架的 ReadTimeout 默认值是 60s,在请求数据正常的情况下 ReadTimeout 也不可能超时,这次的问题主要出在 WriteTimeout,GoFrame 的默认值是 0s,代表不控制超时,但之前的开发者也同样设置为了 60s,导致服务端在处理大量数据时,发生了超时现象。

更深挖之后,才发现 WriteTimeout 的诡异之处,当 WriteTimeout 发生之后,服务端不会即时返回超时消息,而是需要等服务端真正处理完之后,返回数据时,才会返回一个空数据,即使服务端正常写入返回数据,但都会强制为空数据返回,导致请求客户端报错。这种表现,看起来就像是 WriteTimeout 不仅没有起到应有的作用,在错误设置的情况下,还会起到反作用,使服务响应错误。WriteTimeout 无法即时生效的问题,也同样有其他人反馈了:1. Diving into Go's HTTP server timeouts;2. net/http: Request context is not canceled when Server.WriteTimeout is reached。可能是网上反馈的人多了,go 官方推出了一个 TimeoutHandler,通过这个设置服务端超时,即可即时返回超时消息。仿照官方的 TimeoutHandler ,即可在 GoFrame 框架中也实现自己的超时中间件。

至于 WriteTimeout 为啥不起作用,个人猜测主要原因在于 go 服务每接收到一个请求,都是另开一个协程进行处理,而 goroutine 无法被强制 kill,只能自己退出,通常是要等到 goroutine 正常处理完之后才能返回数据,WriteTimeout 只是先强制写一个空数据占位,返回还是得等 goroutine 正常处理完。

所以正常的 go 服务,在使用类似于 TimeoutHandler 中间件的时候,也最好让 goroutine 尽可能快的退出,一种简单的方法是:1. 设置请求的 context 为 context.WithTimeout;2. 分步处理数据,每一步开始前都先检查请求传入的 context 是否已经超时;3. 若已经超时,则直接 return,不进行下一步处理,快速退出 goroutine。

这次问题排查,碰到的最大障碍在于,前几次反馈的 case 难以复现,客户端请求报错和服务器返回的时间一致也不会让人往超时的角度去想,在拿到一个能稳定复现的 case 之后,才死马当活马医,先调一下超时参数试试。

关于 go 服务超时的文章,其实之前也看过,但没碰到具体问题,名词也就仅仅只是名词,很难理解背后的含义和其中的坑点,实践才能出真知 ╮(~▽~)╭。

关于超时问题,也曾看到过有人碰到一个长链接服务的问题,现象是这样的:后端服务宕机之后,客户端可能需要很久才会感知到,原因在于 tcp 的超时重传机制,在 linux 中,默认会重传 tcp_retries2=15 次(即 16 次才会断开连接),而 TCP 最大超时时间为 TCP_RTO_MAX=2min,最小超时时间为 TCP_RTO_MIN=200ms。即在 linux 中,一个典型的 TCP 超时重传表现为:

| 重传次数 | 发送时间 | 超时时间 |

|---|---|---|

| -1(原始数据发送) | 0s | 0.2s |

| 0 (第 0 次重传) | 0.2s | 0.2s |

| 1 | 0.4s | 0.4s |

| 2 | 0.8s | 0.8s |

| 3 | 1.6s | 1.6s |

| 4 | 3.2s | 3.2s |

| 5 | 6.4s | 6.4s |

| 6 | 12.8s | 12.8s |

| 7 | 25.6s | 25.6s |

| 8 | 51.2s | 51.2s |

| 9 | 102.4s | 102.4s |

| 10 | 204.8s | 120s |

| 11 | 324.8s | 120s |

| 12 | 444.8s | 120s |

| 13 | 564.8s | 120s |

| 14 | 684.8s | 120s |

| 15 | 804.8s | 120s |

| 断开连接 | 924.8s(≈15min) |

所以客户端需要在 15 分钟之后才能感知到服务端不可用,如此,仅靠 TCP 自身的超时机制,很难发现服务端是否宕机/不可用,长链接不释放,进而可能导致客户端不可用且无感知,所以在长链接服务中,需要有其他的手段来保障服务稳定/可用性(eg:心跳探活)。

Refer to: context canceled,谁是罪魁祸首

从官方的 net/http 包中可以知道,go 服务在接收请求时,会同时生成一个协程监控连接状态,当发现连接有问题(eg:客户端设置请求超时主动断开)时,会将该请求对应的 context cancel 掉,这时服务端如果再继续使用该 context 时,就会报错「context canceled」。当然,如果服务端发生错误,也同样会导致请求对应的 context cancel 掉。

服务端主动 cancel context 的好处在于可以快速释放资源,避免无效的请求继续执行(当然也得业务代码上主动去感知 context 是否 cancel,从而及时退出);坏处在于,如果服务端需要上报这个请求发生的错误(一般在后置中间件中进行错误上报),这个时候上报错误的请求需要另外生成一个新的 context,绝不能直接使用现有的 context,因为已有的这个 context 已经 cancel 掉了,继续使用会导致上报错误的请求发送失败,达不到上报的目的。

2024-03-03 12:26:15

前些日子,小叔说堂弟的学习有点不太能跟上了,让 Shaun 和堂弟聊聊,回想十几年前, 父亲也是这样找堂哥的,仍记得那年的寒暑假,算是 Shaun 进步最快的一年,也是奠定 Shaun 后续学习方法的一年,现在轮到小叔来找 Shaun ,虽说不能当面聊,指导效果会大打折扣,而且当年堂哥教的具体方法也早已忘记,转化为自己的思想和方法,所以 Shaun 也只能把自己的东西说给堂弟,也算是某种意义上的传承。

Shaun 一直认为学习是有天赋,这种天赋体现在学习某一方面的事特别长记性,看个几眼就能完全记在脑海里,还能灵活变通记得的东西。同时,学习也需要方法的,在天赋不够的情况下,有个好的学习方法也能事半功倍。最后,学习是需要积累的,所谓的积累,就是增长见识,多练习,就中学而言,积累就是多做不同的题,同一类但举一反三的变题,在积累的足够多的情况下,考场上同样的题至少都是见过的,没有太多的心理压力,自然会好解一些。

当然中学的学习毕竟是通过考试来验证结果的,而这个结果才是最重要的(也算是一种唯结果论,不过现实如此,社会如此,没人能逃过,只以成败论英雄,唯一需要注意的是英雄很多时候是有保质期的,扯远了 😅),所以应试技巧也很重要,考试是一个在一定时间内如何得分最多的任务,即使是所有的题都能解,但超时了也没用,更何况大部分人只能解一部分,所以对于这种任务,最好是先快速扫一下卷子,心里先有个数(大概都是些啥题),后面再按部就班的的做,性价比低(要花费大量时间,得分又低)的后面再解。当然在绝对的实力面前,所谓的应试技巧都是虚幻,打铁还是得自身硬,应试本质上是一个熟练的事,需要大量的练习,简而言之就是多刷题 🤪。

闲话说完了,下面就是正文了,由于 Shaun 是理科生,仅记录 Shaun 还能记得的当年理科六门学科的学习经验。

语文一直是 Shaun 的弱项,不过从 Shaun 现在的经验再回过头去看语文,感觉语文考验的更多是对人生和社会的一种感悟,这种感悟不仅仅只是对于自身的体验,也是对别人人生经历和当时社会的一种体会。在学生时代,大部分人受限于家庭和外部环境因素,自身体验很少有丰富的,只能多体会别人的人生,别人的人生只能依赖多看书(小说传记历史都可以),最重要的是在读的时候能有自己的一些思考,假如自己在别人的处境下会是一种什么心态,会有什么行动,一些好的文章,作者为什么会那样描写,遣词造句。当然语文也有直接需要记忆的,字词拼音,古诗文这种,就全靠记忆背诵了。

中学数学最重要的两个分支就是代数和几何,以及介于两者之间的解析几何,于是也有了数学中最重要的思想——数形结合,抽象的数字有了形状,就不再那么枯燥。熟练使用函数图像以及对应的特点,数学及格就没啥问题了,至于几何,立体空间想象力不够的情况下,也可以加坐标系当解析几何计算了,不过就是时间花的多些。

导数算是函数中最核心的概念(导数以及对应的微分也会在高等数学中贯穿始终),函数导数的几何意义就是对应点切线的斜率,当在实际的物理场景下,导数也有其实际意义,比如路程关于时间的导数就是速度,速度关于时间的导数就是加速度。

数列可以认为是一种纯数字游戏,虽然通项公式或者递推式可以认为是某种函数,但数列本质还是数字自身的规律,这种更多的是经验和一种直觉,发现不了就是不能发现,无从下手也无法计算。

集合和数理逻辑,不等式,极值,推理与证明,对应的反证法。概率与排列组合,这类问题熟记公式,太难的问题,不会就是不会了 🙃。

向量计算,数形结合完美的体现,中学物理的利器,三角函数,向量的内外积,单位向量的意义,这些东西还是只能在练习中画图理解。向量这个数学工具的美,也只能在实际应用中体会,角度,投影,面积,距离(点点/点线/点面距离),坐标变换(旋转/平移/缩放)等等。

英语也是 Shaun 不太在行的,尤其是现在回想 Shaun 整个中学,英语及格的次数都屈指可数,初中英语最后一次考试能及格还是靠初三下死命的记单词,而高中英语也是到高三才能稳定的及格,原因也是单词和语法记少了,更重要的原因是对死记硬背很是反感,甚至由于这个原因还和高二的英语老师对着干,一上英语课 Shaun 就直接出去了,后来还好高三换了个英语老师,给 Shaun 稍微开了一段时间的小灶,就是让 Shaun 每天写篇英语作文,然后针对这篇作文进行指导批改,这种方式很适合 Shaun ,从此也算是踏上了英语及格之路, Shaun 现在依然很感激高三的英语老师。至于英语听力,这个没办法,只能靠多听,以 Shaun 现在的经验看来,每天都有一定的时间处在英语环境下,确实能提高听力水平,多听的频率很重要,不然过一段时间就没那种感觉了。

尤记得高一的物理也有很多次没及格,后来在堂哥的指导下,物理好歹也算是入门了,每次考个 80 分都还算轻松。目前还能记得堂哥教的物理学习方式就是手推公式,当然手推公式同样能应用到数学和化学上。所谓的手推公式就是利用一些基础的公式推导出一个复杂的公式,或者是两个复杂的公司来回推导,能够熟练的手推公式,圆周运动和电磁场问题公式层面的问题就能比较清楚了。至于受力分析,支撑力与面垂直,摩擦力与面平行,杆提供支撑力或许也有拉力,绳只提供拉力,可以假设圆周运动的离心力真实存在,与向心力平衡。至于能量守恒和动量守恒,这个只能多刷题了。

物理是和数学强绑定的一门学科,数学不行,物理不可能会好的,所以要学好物理得先学好数学。

Shaun 算是有一定天赋的,看几遍书上的内容,就基本上都能记住了,不管是无机还是有机化学实验也基本都很清晰会有啥现象,每个元素的性质当时也都能记得,以至于看到一些常见的物质大概就能知道会有啥反应。不过还记得当时对于化学方程式配平, Shaun 还只能靠眼睛看,没啥方法,后来堂哥教了个得失电子法,同时针对性的做了大量的题,让 Shaun 领先全班一个学期熟练使用这个方法,在配平这类问题上基本没怎么丢过分。在刷题的过程中,也可以活用一些书上没见过的公式,曾经有次看到一个理想气体状态方程的公式,发现用这个公式可以很轻松的解释一些化学平衡的移动问题。化学在 Shaun 这里没怎么太刷过题,感觉就靠多看书了,熟记元素和物质的物理化学性质。

生物感觉没太多好说的,就实验而言和化学有点像,但需要记忆的东西更多,最需要计算的题也就是染色体概率和群落数量估计问题了,不过就算不会算,丢分也不多。

刷题是一种很有效的应试技巧,国内的大部分考试都能通过刷题解决,如果解决不了,那就多刷几遍,针对性的刷题会更有效果。

死记硬背也是一种方式,但能活学活用更重要,在使用中记忆会更好,理科有个很重要的思想就是推理,大部分结论或公式都能通过一些简单前提或公式推导出来,可以试试自己推导一些常用的公式(关于推导,数学科普领域有本书叫「天才引导的历程」可以看看),注重平时的练习,不要怕麻烦,熟才能生巧。

至于错题本,得看收集错题的方式,最好是一类题收集在一起,每种解题方式各收集一个经典的题型,后续有时间就翻翻回顾下,就 Shaun 个人的经验,记得很杂的错题本,往往起不到应有的效果,针对性的学习很重要,需要注意的是错题集不要做成了难题/怪题集。

独立思考,本意是指不要人云亦云,需要有自己的思考和看法(这本应该是每个人的必备技能,但没有的人确实不少)。在学习领域,特指在寻求问题答案的过程中,一定先得有个自己的思考过程,苦思不得的问题会更深刻,同时思考的过程也是自己串通知识点的过程,更容易知道自己的盲区。

因材施教,同样也因人学习,每个人在不同的学习环境下学习效率是不同的,有些人需要被人催促,需要更有压力一点才能学的好,而有些人更主动一些,在宽松的环境下学习更有效果。而目前的学校都是填鸭式教育,一视同仁,虽说每个学校的教学风格不太一样,但不一定适合学校内的每个学生,所以需要找到适合自己的方式。

回顾整个高中生涯,对 Shaun 影响最大的其实还是堂哥和高三的英语老师,当时的班主任虽然对 Shaun 也很好,但对 Shaun 的学习和做事方式影响就没那么大,只记得当时班主任常说的一句话——读书是能改变命运的。对于大部分人,读书确实是最可行的出路,其他的路不确定性会更多,虽说读书需要一定的天赋,但国内应试教育的本质注定了努力刷题是能弥补这一部分天赋的,当然,如果有个人能在刷题的路上再稍微指导一下,会走很多弯路,也更容易找到适合自己的学习和思考方式。