2025-10-25 08:00:00

从军事领域中的通信,到末世题材影视中的通联,再到越野中的车队通话,都让我对「无线电」这项技术感到高级和炫酷。可能在更多人的眼中无线电或是《永不消逝的电波》中发报机,亦或是保安大哥手中的对讲机。当你深入去了解的时候会发现,这东西不会那么遥不可及,当然也没有想象中那么简单,差评君的一期视频可以带你更好的了解什么是无线电。

那么什么又是业余无线电?莫非我们只配玩儿些不专业的东西?这里所说的“业余”并非技术角度的专业和不专业,而是指业余业务。业余无线电可以简单的理解为提供给我们这些业余爱好者使用的无线电。业余无线电的英文为 Amateur Radio,业余无线电爱好者称为 Radio Amateur,世界上也普遍称之为 HAM,所以“火腿”也就成为了业余无线电爱好者的代名词。

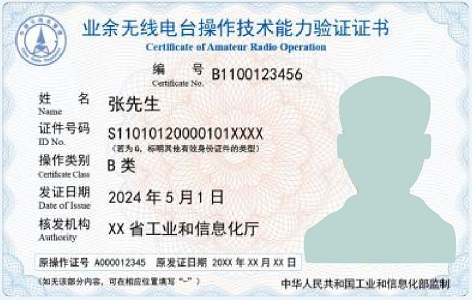

想要合法合规的进行业余无线电操作,首先需要通过业余无线电台操作技术能力验证,类似开车一样你需要先考一个驾照。业务无线电台操作技术能力验证有不同等级,A 类、B 类和 C 类的区别如下:

| 操作类型 | 适用范围 |

|---|---|

| A 类 | 可以申请设置、使用工作在 30-3000MHz 频段且最大发射功率不大于 25 瓦的业余无线电台。 |

| B 类 | 可以申请设置、使用工作在 30MHz 以下频段且最大发射功率小于 15 瓦, 或者工作在 30MHz 以上频段且最大发射功率不大于 25 瓦的业余无线电台。 |

| C 类 | 可以申请设置、使用工作在 30MHz 以下频段且最大发射功率小于 1000 瓦, 或者工作在 30MHz 以上频段且最大发射功率不大于 25 瓦的业余无线电台。 |

申请人初次申请业余无线电台操作技术能力考核,须首先参加 A 类业余无线电台操作技术能力考试。取得 A 类操作证书六个月后可以申请参加 B 类操作技术能力考试。取得 B 类操作证书并且设置 B 类业余无线电台二年后,可以申请参加 C 类操作技术能力考试。

不同于考驾照,业务无线电台操作技术能力验证仅有理论考试,各地的考试报名方式不尽相同,更多的考试细节和题库可以参考业余无线电模拟考试平台。通过考试后,就可以收到业务无线电台操作技术能力验证证书了。

拿到操作证书后,你就可以选择一台心怡的设备了,买完设备后你还需要去验机。这里最重要的一点就是你购买的设备型号必须有国家颁发的核准代码,没有核准代码的设备是无法通过验机的。

针对新手小白的对讲机选购可以参考下面这个视频,只能说没有最好的,从价格、性能、颜值等角度选择适合自己的就好。

我最终选择的是「如意通 6900 DMR」双模对讲机。之所以选择它是早些时间有了解到有 MMDVM 盒子这么一个东西,也想着入坑玩一下,所以就选择了一款有数字模式的对讲机。验机完毕后,就会收到一张中华人民共和国无线电台执照。

相比操作证书,无线电台执照简陋了不少,就是一张纸,所以可以去淘宝买一个保护套装上。此时你就得到了正式的呼号,现在就可以打开对讲机,开始你的第一次联通了:

CQ, CQ, CQ, this is BD1CZP. BRAVO, DELTA, ONE, CHARLIE, ZULU, PAPA. BRAVO, DELTA, ONE, CHARLIE, ZULU, PAPA. Calling CQ and standing by.

CQ,CQ,CQ,这里是 BD1CZP。BRAVO,DELTA,ONE,CHARLIE,ZULU,PAPA。BRAVO,DELTA,ONE,CHARLIE,ZULU,PAPA。呼叫 CQ 并等待回答。

我的呼号是 BD1CZP。翻阅了下资料,我国的呼号由 4 部分构成:

报完呼号后为啥又来了 BRAVO, DELTA, ONE, CHARLIE, ZULU, PAPA 这么一段?这是因为为了避免在信号传播过程受到干扰导致失真或衰减,使得对一些字母的听辨产生困难,在通信中会使用字母解释法复述呼号。

除了标准解释以外,有时候也会使用其他单词替代:

| 字母 | 标准解释 | 其他解释 |

|---|---|---|

| A | ALFA | AMERICA |

| B | BRAVO | BOSTON |

| C | CHARLIE | CANADA |

| D | DELTA | DENMARK |

| E | ECHO | ENGLAND |

| F | FOXTROT | FLORIDA |

| G | GOLF | GERMANY |

| H | HOTEL | HONOLULU |

| I | INDIA | ITALY |

| J | JULIETT | JAPAN |

| K | KILO | KILOWATT |

| L | LIMA | LONDON |

| M | MIKE | MEXICO |

| N | NOVEMBER | NORWAY |

| O | OSCAR | ONTARIO |

| P | PAPA | PETER |

| Q | QUEBEC | QUEEN |

| R | ROMEO | RADIO |

| S | SIERRA | SUGAR |

| T | TANGO | TOKYO |

| U | UNIFORM | UNITED |

| V | VICTOR | VIRGINIA |

| W | WHISKEY | WASHINGTON |

| X | X-RAY | |

| Y | YANKEE | YOKOHAMA |

| Z | ZULU | ZANZIBAR |

QSL 在通信用的 Q 简语中是“收妥了”“给收据”的意思。QSL 卡片是业余电台特有的一种确认联络或收听的凭证,每个电台都应该有自己的 QSL 卡片。QSL 卡片一般长为 14-15 厘米,宽为 9-10 厘米,除了必须印有醒目的本台呼号外,还应该包含如下内容:

设计了一个自己的 QSL 卡片,如有需要源文件可单击下载:正面 & 反面。

2025-10-19 08:00:00

十一之前看了原子能 UP 主的一期视频,最开始只是有感于当前工作中的代码开发,后来又有感于工作和生活,想着记录下来,又担心酸腐味太重就没写。十一回来,玩儿了两天,出了趟差,愈发感觉还是应该记录下,待回头看时至少可供自嘲。

视频中讲到了一个“鸿沟理论”,高科技产品在市场营销过程中遭遇的最大障碍就是早期市场和主流市场之间存在的鸿沟,能否顺利的跨越鸿沟进入主流市场成功赢得实用主义者的支持决定了一个产品的成败。还有个“巴斯扩散模型”和这个理论很类似,原来还基于它做过一些预测模型。

早期市场中的产品就是我们通常说的 MVP。MVP 最重要的是速度,需要快速在市场中得到验证。所以从风险和收益的角度出发,在 MVP 开发的时候大家会快速地实现产品功能,一些细节(例如代码质量)往往就没那么重要。这一点我很认同,但是这里有个前提是面向市场的产品,在我的工作中,会有不少“就是要做”的事情,一定程度上是“刚需”,做得好做的差都得用。那这个时候大家又会怎么选择呢?我观察到的情况是大部分人还是会选择快速上线,因为要“拿结果”,虽没有市场去评价你,但你的老板会去评价你。

视频中给到的结论是:任何时候都不适合重构。经过早期市场的验证,当多个玩家都在拼命渡河赢得主流市场时,如果你慢了就很容易被赢家通吃,所以此时此刻你仍需要同时间赛跑。当终于在主流市场站稳脚跟后是不是真的就可以重构了,答案是依旧不行,因为这个时候已经积累了足够的技术债,重构的成本已经远远高于 MVP 时期。此时在风险和收益之间的人们往往不会为了一个收益不明朗的价值回报去承担一个不小的成本。尤其是在当前的环境下,没有铁饭碗的人不会想着为别人做嫁衣,有铁饭碗的人不会没事儿给自己找麻烦。

我给到的观点是:任何时候都适合重构,而且我认为这并不偏激。重构不一定代表需要大刀阔斧,有些时候你的改动甚至可以其他人都无感,只要对你的后续开发和维护有益,你认同这一点,就有动力去做。如果你没打算在团队长待,或者你就想当个甩手掌柜,亦或是你并非正编,那权当我没说(这三种情况我认为存在且普遍)。当真的需要启动治理需要推翻重来时,我们就需要现实些,此时可能需要更量化的风险披露,更好的上价值,更好的汇报,拉更多的人下水,事情才更容易如你所愿。

重构是有意义的,好一句废话,但我还是会时不时的想一想,不想连去做的勇气都不再会有。做多少,何时做,如何做,这里面的“度”每个人的想法就千差万别了,别因为此太过影响自己的绩效,那就尝试做一些,如果你超会上价值,也全当我多虑了。还有一点我认为需要多践行工程师文化,多一些思考,多一些规范,多 Review 一下自己的代码,这些不会太影响和时间赛跑的。我不图未来接手我代码的人夸我写的漂亮,只求不会骂我的代码是屎山。

在之前的博客中有聊到自己的第二次职业焦虑,一年过去了,焦虑缓解了,但新的问题或者说想法变多了。谈及自己我都会说我是一个风险厌恶的人,这点到现在也没有太变(所以说改变一个人的一些想法真的挺难的),但我对风险有了新的认知。一次出差飞机上三个小时听了关于塔勒布的一个播客,还没来得及更深入的去了解,但让我记住了一个词“勇气”。对于工作而言,重构往小了说可以是内部职责的一次调整,往大了说可以是寻求一个新的外部机会,我能找出促使我要去这么做的千万个理由,但确没有太多去这么做的“勇气”。

我会更在意失去的,好比上面说的,风险是确定的(失去的),但收益是不明朗的(确定不会是一个更深的坑)。相比一年前,我最大的改变在于动起来了,确实缓解焦虑最好的方式就是行动起来。我们需要更加深入地剖析要不要做出变动,但不应持续地陷入剖析而不自拔。动起来,担心失去就先“小”动起来,不用让人看见(让人看见可能对你也没好处),自我发起的改变也不应是一蹴而就的,多些准备会让你少些担忧。

这段时间刷到短视频上的一句话:听说过上班累死的,没听说过不上班饿死的。我希望可以更加阳光的理解这句话,拼搏奋斗仍应是我们要去追求的,只是说哪怕做错了什么,你又能失去多少呢,相信只要能远离黄赌毒,就不至于把自己玩儿死。

最近一年的感觉自己有些腐朽味,四年前的我还能一个人去摩旅,今年的我连近郊都没怎么去,貌似生活也进入了急需重构的阶段。但还不如工作,都还谈不上有没有动力去改变,连想要的生活的样子似乎都有些模糊了。最近看到豆瓣上也可以听播客了,之前都是在苹果自带的 APP 上听(简洁又没广告),但豆瓣推给我的一个播单甚得我意,有点豆瓣书籍和影视年度榜单的味道。随即发了个朋友圈分享了下,一个朋友回复到“这岂不是会天天蹿到你出去玩”,我回复到“出去玩就不听了,出不去才只能听听人家的过过瘾”。这一刻,我有在想是没了出去的勇气,还是连出去的想法都没了?

昨晚在短视频上刷到一个在澳大利亚的华人,记录了一些和当地人的生活日常,去过一次澳大利亚,那种地广人稀的氛围自己还是比较喜欢的。无论是播客还是短视频,难道真的是娱乐至死,或许可以从减少些刷短视频开始,立马走出去不现实,但把这两年没怎么读的书补一补还是可以试一试的。

前几天和部门里面年轻的同事聊到大学的专业(怎么就聊到这想不起来了,上了年纪确实记性不好),还能记得管理学老师的一句话:读万卷书不如行万里路,行万里路不如交万名友,交万名友不如名师之路。名师指路可遇不可求,庆幸求学期和工作期间能遇到几位带我的好师傅,行万里路真的可以体验更多(人生百态皆在其中),不过经济性不如读书。真的有好久没有好好的读几本书了,之前可以挑灯夜读,很想搞清楚为什么现在不行了,想了想也没太想明白,也许没那么重要搞清楚,有这时间去读更好些。那天我还说他们这些年轻人正值好时候(回头想想这话有点儿爹味儿),自己已经有些老了,感觉在重构生活的路上,借口多了太多,虽然每个人的情况各不相同,所以到底在害怕失去什么呢?这个答案就留在我完成重构那天再补上吧,希望有这一天,希望这一天不要太晚。

2025-08-09 08:00:00

微调(Fine-tuning)是深度学习中迁移学习的一种方法,其将现有模型已经学到的知识作为学习新任务的起点。虽然微调表面上是模型训练中使用的一种技术,但它与传统意义上的“训练”截然不同。为了消除歧义,在这种情况下通常将传统意义上的“训练”称为预训练(Pre-training)。1

与微调类似的另一个概念称之为后训练(Post-training),两者均发生在预训练之后,其目的也都是为了进一步提升模型的效果,通常两者可以理解为相同的概念。从优化的发起人角度出发:当终端用户希望模型可以更好的适配自己的领域知识,则需要进行的操作称之为微调;当模型开发者希望可以更好的将模型与人类的价值、道德和预期保持一致,则需要进行的操作称之为后训练。2

从本质上讲,磨练一个预训练基础模型的能力要比从头开始训练一个新模型更容易,也更省钱,因为预训练已经获得了与当前任务相关的广泛知识。对于具有数百万甚至数十亿个参数的深度学习模型尤其如此,例如在自然语言处理(NLP)领域的大语言模型(LLM)或卷积神经网络(CNN)和视觉转换器(ViT)(用于计算机视觉任务,例如图像分类、对象检测或图像分割等)。

通过迁移学习利用先前的模型训练,微调可以减少获得适合特定用例和业务需求的大模型所需的昂贵算力和标记数据量。例如,微调可用于调整预训练大语言模型的对话语气或预训练图像生成模型的图片样式,还可用于使用专有数据或领域特定的专业知识来补充模型的原始训练数据集。

微调是需要进一步训练模型的技术,模型的权重已经通过先前的预训练得到了更新。使用基础模型的先前知识作为起点,通过在任务特定的较小数据集上进行训练来对模型进行微调。

虽然从理论上讲,任务特定的数据集都可以用于初始训练,但在小数据集上从头开始训练一个大模型可能会存在过拟合的风险:模型可能会在训练示例中学习得到良好的表现,但对新数据的泛化能力却很差。这会导致模型不适合给定的任务,也违背了模型训练的初衷。 因此,微调可以兼具两者的优势:利用对大量数据进行预训练所获得的广泛知识和稳定性,并训练模型对更详细、更具体概念的理解。

从参数角度,我们可以将微调分为全参数微调(Full Fine-tuning)和部分参数微调(Repurposing):

从数据角度,我们可以将微调分为监督微调(Supervised Fine-tuning)和无监督微调(Unsupervised Fine-tuning):

从方式角度,我们可以将微调划分为指令微调(Instruction Fine-tuning)和对齐微调(Alignment Fine-tuning):

在进行模型微调时我们需要关注显存的消耗,以确保在当前的硬件环境中可以正常进行微调。在进行模型微调时,显存消耗主要同如下因素有关:

以全参数微调一个 1B 模型为例,所需的显存大致为 12GB(模型参数:2GB,梯度:2GB,优化器状态:8GB)。在使用部分参数微调时,模型参数本身不变,需要微调的参数会大幅度减少,因此梯度和优化器状态所需的显存也会大幅度减少。在应用一些量化技术后,例如使用 INT8 精度进行微调,则所有部分的显存占用均会相应的减少。

参数高效微调部分主要参考了 llm-action 项目。

参数高效微调(Parameter-Efficient Fine-Tuning)是指固定大部分预训练模型的参数,仅微调少量或额外的模型参数的微调方法,从而可以极大的降低计算成本。参数高效微调可以从方法的角度可以分为三类 3:引入新参数(Addition-based),微调部分参数(Selection-based)和重参数化(Reparametrization-based),其中引入新参数又可以划分为适配器方法和软提示方法两种。

在实战过程中我们可以使用 Huggingface 开源的 PEFT 扩展库进行参数高效微调,作为 Huggingface 开源项目其可以与 Transformers,Accelerate 和 Diffusers 等多个开源库无缝衔接使用。在官方文档中我们可以查看支持的微调类型和任务类型。

Prefix Tuning 4 是在输入的 token 前构造与任务相关的 virtual token 作为前缀,在微调的时候仅更新前缀部分的参数。

针对不同的模型结构,构造的前缀也有所不同:

作者发现直接更新前缀的参数会导致训练不稳定,因此在前缀之前添加了 MLP 结构,在训练完成后 MLP 部分的参数无需保留,仅保留前缀的参数即可。同时作者也针对前缀使用多少个 virtual token 以及前缀放置的位置对于微调的性能影响进行了相关实验,细节请参考论文原文。

Prompt Tuning 5 可以看作是 Prefix Tuning 的简化版本,其为每个任务定义不同的 Prompt,然后拼接到数据上作为输入。

Prompt Tuning 仅在输入层添加 token,不需要像 Prefix Tuning 那样添加 MLP 结构解决训练问题。通过实验发现,随着模型参数的增加,Prompt Tuning 的效果会逼近全参数微调的效果。

实验还发现,与随机和使用样本词汇表的初始化相比,采用类标签初始化的微调效果更好,但随着模型参数的增加,效果差异会消失。同时 Prompt 的 token 长度在 20 左右可以获得不错的效果,同样随着模型参数的增加,token 长度带来的增益会消失。

P-Tuning 6 将 Prompt 转换为可学习的 Embedding 层,再通过 MLP+LSTM 结构对 Prompt Embedding 进行处理。

对比 Prefix Tuning,P-Tuning 增加了可微的 virtual token,但仅作用于输入层,没有在每一层都添加。同时,virtual token 的位置也不一定是前缀,其插入的位置是可选的,目的是将传统人工设计的 Prompt 模板中的真实 token 替换为可微的 virtual token。

实验发现随机初始化 virtual token 容易陷入局部最优,因此通过一个 Prompt Encoder(即 MLP+LSTM 结构)对其进行编码可以获得更好的效果。

Prompt Tuning 和 P-Tuning 存在如下问题:

考虑到上述问题,P-Tuning v2 7 利用深度提示优化(例如:Prefix Tuning)对 Prompt Tuning 和 P-Tuning 进行改进,类似 Prefix Tuning,其在每一层都加入了 Prompt token 作为输入。

P-Tuning v2 还通过移除重参数化编码器、针对不同任务采用不同提示词长度、引入多任务学习、使用传统分类标签范式等方法进行模型改进。实验表明 P-Tuning v2 可以在不同规模和不同任务中实现与全量微调相媲美的效果。

Adapter Tuning 8 设计了一个 Adapter 模块,并在每个 Transformer 层中插入两个 Adapter 模块,在微调时仅更新增加的 Adapter 模块和 Layer Norm 层中的参数。

Adapter 模块由两个前馈层和一个非线性层组成。第一个前馈层将 Transformer 的输入从 $d$ 维(高维)映射到 $m$ 维(低维),其中 $m \ll d$。通过控制 $m$ 的大小可以限制 Adapter 模块的参数量。中间通过非线性层后,第二个前馈层再将 $m$ 维映射回 $d$ 维作为 Adapter 模块的输出。同时通过 Skip Connection 将 Adapter 的输入也添加到 Adapter 的输出中,这样可以保证即便 Adapter 最开始的参数值接近 0,通过 Skip Connection 的设置也可以保证训练的有效性。

神经网络包含很多全连接层,其通过矩阵乘法实现。很多全连接层的权重矩阵是满秩的,针对特定任务微调后,模型的权重矩阵其实具有很低的本征秩(intrinsic rank),因此将参数矩阵投影到更小的空间仍可以得到有效的学习。LoRA 9 的核心思想就是通过低秩分解降低特征矩阵的参数量,从而以较小的参数量来实现大模型的间接训练。

在涉及到矩阵相乘的模块中,在其旁边增加一个新的通路,通过第一个矩阵 $A$ 将维度从 $d$ 降至 $r$,在通过一个矩阵 $B$ 将维度从 $r$ 升回 $d$,其中 $r \ll d$。

在微调时,仅更新上述两个矩阵的参数,再将两条通路的结果相加作为最终的结果,即 $h = W_0 x + B A x$。训练时矩阵 $A$ 通过高斯函数初始化,矩阵 $B$ 初始化为零矩阵,这样训练开始时 $B A = 0$,从而可以确保新的通路对模型的结果没有影响。

在 Attention 模块中,权重矩阵包括用于计算 Q,K,V 的 $W_q$,$W_k$,$W_v$ 以及多头注意力的 $W_o$,实验表明保证权重矩阵的种类数量比增加秩 $r$ 的大小更为重要,通常情况下 $r$ 选择 4,8,16 即可。

IA3 10 不同于 LoRA 学习低秩权重,而是通过学习向量($l_k$,$l_v$,$l_{ff}$)对模型的部分参数进行加权实现对一些激活层的抑制或放大,同时优化损失函数以适应少样本学习。

Huyen, Chip. AI Engineering: Building Applications with Foundation Models. O’Reilly Media, Incorporated, 2024. ↩︎

Lialin, Vladislav, Vijeta Deshpande, and Anna Rumshisky. “Scaling down to scale up: A guide to parameter-efficient fine-tuning.” arXiv preprint arXiv:2303.15647 (2023). ↩︎

Li, Xiang Lisa, and Percy Liang. “Prefix-tuning: Optimizing continuous prompts for generation.” arXiv preprint arXiv:2101.00190 (2021). ↩︎

Lester, Brian, Rami Al-Rfou, and Noah Constant. “The power of scale for parameter-efficient prompt tuning.” arXiv preprint arXiv:2104.08691 (2021). ↩︎

Liu, Xiao, et al. “GPT Understands, Too.” arXiv preprint arXiv:2103.10385 (2021). ↩︎

Liu, Xiao, et al. “P-tuning v2: Prompt tuning can be comparable to fine-tuning universally across scales and tasks.” arXiv preprint arXiv:2110.07602 (2021). ↩︎

Houlsby, Neil, et al. “Parameter-efficient transfer learning for NLP.” International conference on machine learning. PMLR, 2019. ↩︎

Hu, Edward J., et al. “Lora: Low-rank adaptation of large language models.” ICLR 1.2 (2022): 3. ↩︎

Liu, Haokun, et al. “Few-shot parameter-efficient fine-tuning is better and cheaper than in-context learning.” Advances in Neural Information Processing Systems 35 (2022): 1950-1965. ↩︎

2025-07-05 08:00:00

本节将介绍如何将一张低分辨率的图片转换成一张高分辨率高质量的图片。

为了对比提升分辨率后的图片质量,我们先下载一张原始的高清图片 1,通过 ImageMagick 命令将其转换为一个低分辨率低质量的图片,未来基于这张转换后的图片进行分辨率和质量的提升,再与原始图片进行对比验证提升的效果。

magick toucan-raw.jpg -resize 512x -quality 10 toucan-low-res.jpg

单击左侧 按钮进入 Upscaling 界面,将上面生成的低分辨率图片拖入 Assets 中,之后再拖入到 Upscale 面板的图片区域。

安装的 SDXL 模型包中包含一个 SwinIR 分辨率提升模型。选择该模型并添加如下的正向和负向提示词:

a vibrant bird, detailed, a high contrast, inviting warmth, sunlit elements, dynamic composition, 35mm lens, 1/2.8, environmental context, detailed har photographyblurry, out of focus, over saturated, text+++将 Creativity 和 Structure 保持默认值 0,单击 按钮生成图片。生成完毕后在 Assets 中的低分辨图片上右键,单击 按钮选择进行对比,单击 Images 选项卡回到新生成的图片页面查看对比效果。

从如下的对比中可以看出,生成的图片具有更多的细节,这样我们就可以在更高的分辨率下获得更加清晰锐利的图像。

单击画布上方的 Exit Compare 退出对比,在生成的图片上右键,单击 按钮可以在新窗口中打开图片,之后则可以使用鼠标进行放大来观察图片细节。

除了基础的分辨率提升以外,还有一些高级选项可以用来控制分辨率提升后的图片与原始图片的相似程度以及在提升分辨率过程中的创意性。Creativity 参数用于设置提示词控制图像生成的创意性,从而控制与原始图像的差异程度,值越大表示越具有创意性。Structure 参数用于确保分辨率提升过程中图像中的元素与原始图像中的元素的形状和位置匹配,值越大表示越会严格遵守原始图片的结构。

同时也可以调整生成的模型及其相关参数,例如:Scheduler 和 CFG Scale 等。

如果在提升分辨率的过程中还希望调整图片的风格,你可以尝试使用不同的提示词,例如下面是一个绘画风格的提示词:

a painting of a vibrant bird, oil painting, deep impasto, glazed brushstrokes

我们适当增加 Creativity 的值到 8,减少 Structure 的值到 -4,这样可以给到模型更多的自由度重新构思一些细节。最后我们来综合对比原始图片、低分辨率图片、提升分辨率后的图片以及调整风格的图片:

至此,我们 Invoke AI 101 系列的 6 节课程就全部结束了,希望大家能够通过这 6 节课程对 Invoke AI 的功能有一个基础的认知。也期待大家能够进一步探索 Invoke AI 的高级功能,去创造更多自己喜欢的图片。

2025-06-28 08:00:00

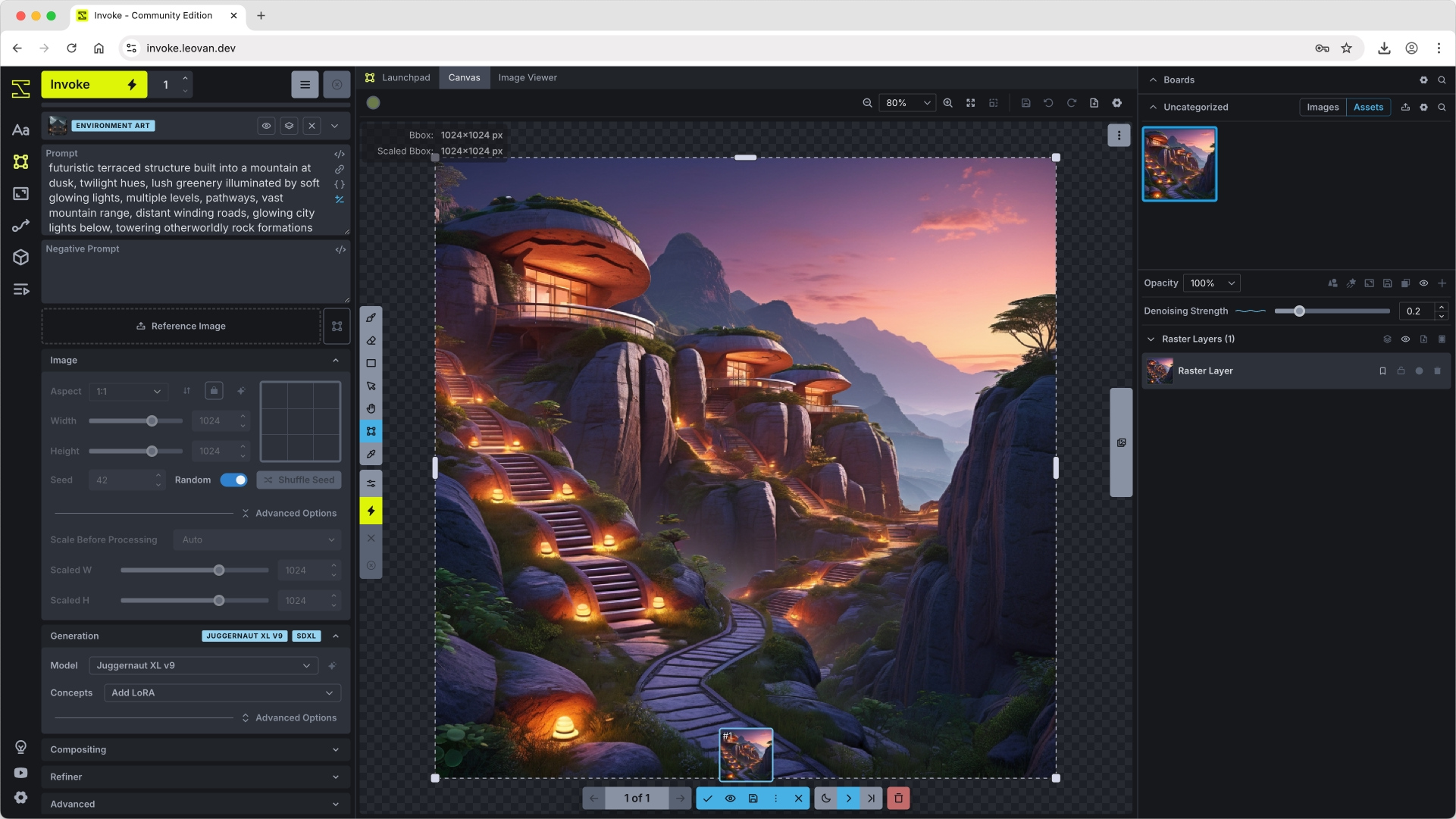

本节将介绍在使用画布进行创建和组合生成新的图片的过程中使用到的核心工具。

首先,我们使用 Juggernaut XL v9 模型和如下提示词生成一张基础图片留作备用:

提示词模板:

Environment Art

正向提示词:

futuristic terraced structure built into a mountain at dusk, twilight hues, lush greenery illuminated by soft glowing lights, multiple levels, pathways, vast mountain range, distant winding roads, glowing city lights below, towering otherworldly rock formations

为了保证可复现性,在生成这张图片时可以将随机数种子 Seed 固定,此处设置为 42。

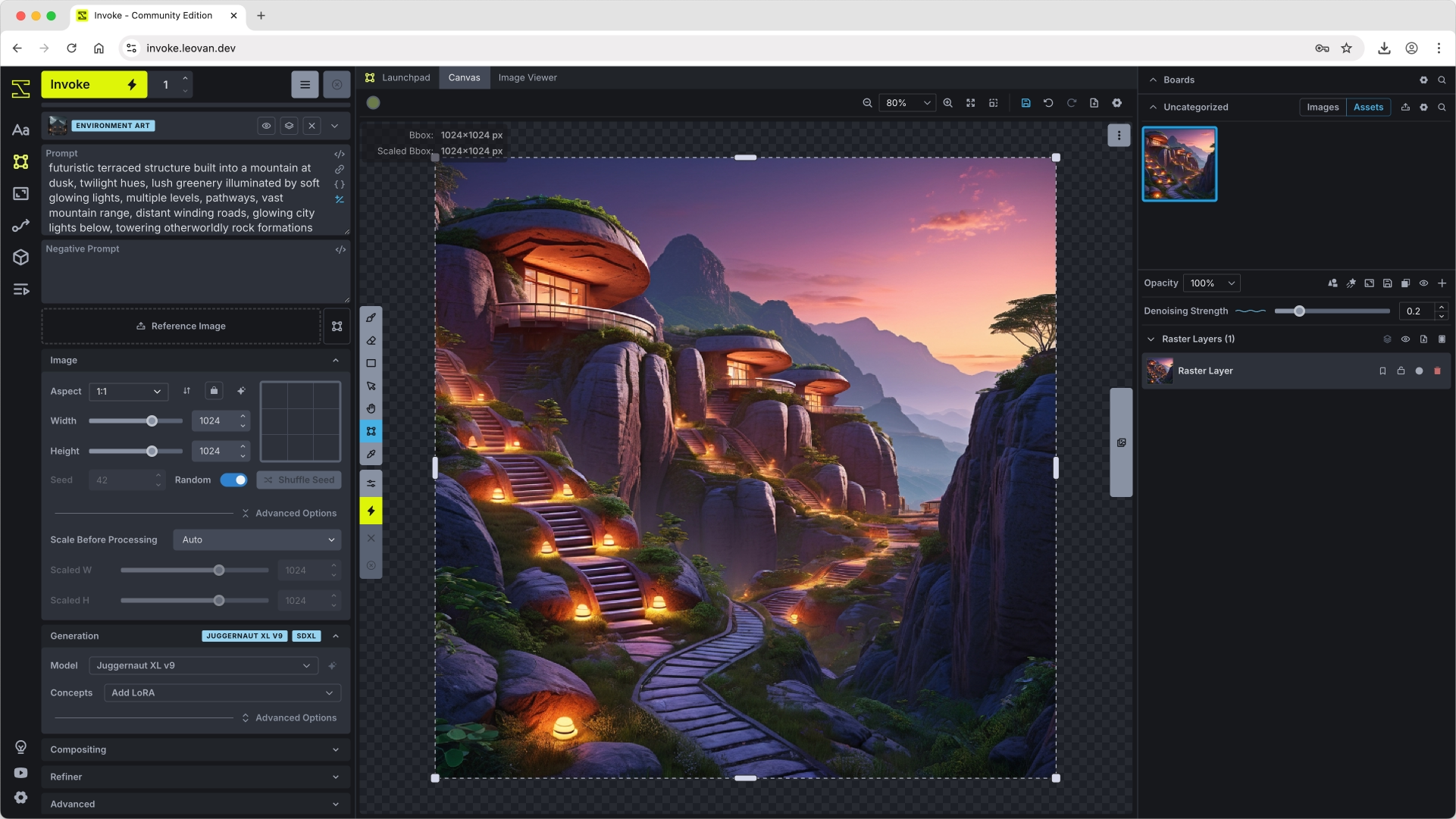

将生成的图片拖入画布并创建一个新的 Raster Layer。在画布上单击 Bbox 按钮,此时图片的周围将显示一个边界框,使用鼠标按住可以拖动边界框的位置,放在边界框的四角可以调整边界框的大小。

将边界框移动到画布的一个完全空白的区域,此时边界框中没有任何 Raster Layer 的内容,单击 会生成一张新的图片。

将边界框移动到画布的一个包含部分 Raster Layer 内容的区域,单击 会将空白的部分补全,通常称之为 Out Painting 或 Infilling。

如果边界框和 Raster Layer 完全重合,单击 将会基于当前 Raster Layer 中的内容重新生成新的图片,通常称之为图像到图像(Image2Image)。

修复蒙版(Inpaint Mask)用于控制在边界框中哪些区域会被修改。在图层中单击 + 新建一个 Inpaint Mask 图层。单击画布上的 按钮后,则可以在画布上绘制所需要修改的区域。

此时可以将边界框进行缩放并移动到关注的指定区域。从左侧的 Image 面板中可以看到边界框的大小为 320x320。

但在图片生成过程中,仍然会以 1024x1024 分辨率进行生成,再通过缩放填充到边界框中。由于先生成了分辨率更高的图片,再进行的缩放,此时生成的部分可以具有更多的细节。这使得我们可以在不牺牲图片质量的前提下,对于图片的复杂区域进行优化。

修复蒙版可以让我们很方便的在图片中添加、移除和改变元素。例如,我们希望在楼梯台阶上添加两个人,可以按照如下步骤进行操作:

two people。0.7,单击 按钮启动生成。可以看出,在修复蒙版区域内,根据 Raster Layer 的修改和提示词的修改成功的在台阶上添加了两个人。

2025-06-20 08:00:00

本节将介绍图片生成使用到的 AI 模型和概念适配器,我们将讨论提示词和模型的训练方式是如何最终决定提示词对生成图片的有效性。

在图片生成过程中你需要认识到提示词并非在任何时候都是有效的。相同的提示词在一个模型上可以获得很好的生成效果,但在另一个模型上可能无法生成所需的图片。这是由于模型训练所使用的图片和图片的标注文本不同所导致的,因此模型的提示词指南会格外重要。这也是为什么训练自己的模型会更好,因为你完全清楚在训练模型时所使用的标注文本。

在本节教程中我们不会讨论如何训练模型,我们将重点介绍不同模型之间的差异,展示它们如何影响图片生成的过程。除此之外我们还会讨论概念适配器(通常也称为 LoRA),来帮助你更好的理解相关工具。

进入模型管理页面,在添加模型选项卡处选择 HuggingFace,输入 cagliostrolab/animagine-xl-4.0 下载 Animagine XL 4.0 模型。Animagine XL 模型与其他的通用模型有很大的不同,Animagine XL 模型是一个动漫主题的 SDXL 微调模型。Animagine XL 4.0 基于 Stable Diffusion XL 1.0 进行重新训练所得,它使用了 840 万张不同来源不同动漫风格的图片进行微调。

Animagine XL 模型使用了一套自有的数据标注方法进行训练,提示词指南如下图所示:

整个提示词包含 6 个部分:

1girl/1boy/1other。remilia scarlet。touhou。safe, sensitive, nsfw, explicit。masterpiece, high score, great score, absurdres。建议的负向提示词如下:

lowres, bad anatomy, bad hands, text, error, missing finger, extra digits, fewer digits, cropped, worst quality, low quality, low score, bad score, average score, signature, watermark, username, blurry

Animagine XL 模型支持一些特殊的标签用于控制图片生成。质量标签直接影响生成图像的整体质量和细节水平。可用的质量标签有:masterpiece,best quality,low quality,worst quality。

masterpiece, best quality

low quality, worst quality

与质量标签相比,分数标签可以对图像质量进行更细致的控制。在 Animagine XL 模型中,它们对输出质量的影响更大。可用的分数标签有:high score,great score,good score,average score,bad score,low score。

high score, great score

bad score, low score

时间标签允许根据特定时间段或年份来控制生成图片的艺术风格。这对于生成具有特定时代艺术特征的图像非常有用。支持的年份标签有:year 2005,year {n},year 2025。

year 2007

year 2023

利用如下正向和负向提示词分别使用 Animagine XL 4.0 模型和 Juggernaut XL v9 模型生成图片。

1boy, black hoodie, white spiky punk hair, nose piercing, standing against a brick wall, masterpiece, best quality, high score, great scorelowres, bad anatomy, bad hands, text, error, missing finger, extra digits, fewer digits, cropped, worst quality, low quality, low score, bad score, average score, signature, watermark, username, blurry同时,为了比较提示词在不同模型中对生成图片的影响,再利用如下正向和负向提示词分别使用 Animagine XL 4.0 模型和 Juggernaut XL v9 模型生成图片。

1boy, black hoodie, white spiky punk hair, nose piercing, standing against a brick walllowres, bad anatomy, bad hands, text, error, missing finger, extra digits, fewer digits, cropped, signature, watermark, username, blurry为了确保可复现,手动将随机数种子固定设置为 42,生成的图片如下:

不难看出,从正向和负向提示词中删除关于图片质量的关键词后,Animagine XL 4.0 模型生成的图片有显著的画质降低,而 Juggernaut XL v9 模型生成的图片质量变化并不大。实验说明提示词在不同的模型中效果存在差异,你必须了解模型的训练过程才能更好的使用提示词生成所需的图片。

上述问题就导致了概念适配器的诞生,通过自己训练概念适配器,你可以完全掌握对于模型的修改。进入模型管理页面,在添加模型选项卡处选择 HuggingFace,输入 nerijs/pixel-art-xl 下载 Pixel Art XL 概念适配器。利用如下正向和负向提示词分别使用 Animagine XL 4.0 模型和 Juggernaut XL v9 模型生成图片。

1boy, black hoodie, white spiky punk hair, nose piercing, standing against a brick wall, masterpiece, best quality, high score, great score, pixel art stylelowres, bad anatomy, bad hands, text, error, missing finger, extra digits, fewer digits, cropped, worst quality, low quality, low score, bad score, average score, signature, watermark, username, blurry在 Generation 中添加概念适配器 pixel-art-xl 并启用:

Pixel Art XL 概念适配器用于生成像素风格的图片,生成的图片如下:

需要注意,LoRA 这类概念适配器与用于训练的原始模型之间存在关联。概念适配器可以理解为一个模型的上层封装,其扩展和增强了某些概念。将其放在另一个模型上,其仍可以将这个概念应用到新的模型上,但质量可能会有所下降。这是因为训练概念适配器的底层模型与当前应用的模型可能有着不同的架构和假设。也就是说 LoRA 这类模型并不是一个完全独立的模型,而是一个专门为某个基础模型构建的适配器,但如果两个模型本质上非常相似,则 LoRA 具有一定的可移植性。