2026-02-06 08:00:00

最近一个月,我不断被 OpenClaw 的消息轰炸,似乎它无所不能,重新定义了生产力。于是我对它产生了强烈的好奇:OpenClaw 到底能帮我做什么?

为了搞清楚这个问题,我分别在 Cloudflare Workers 和 Ubuntu 24 虚拟机(集成 GUI 浏览器环境)完成了部署与测试。以下是详细的部署过程与使用体验。

使用 cloudflare/moltworker 可以将 OpenClaw 便捷地托管在 Cloudflare Workers 上。

此方案的前提是订阅 Cloudflare 的 Workers Paid 计划(5 美元 / 月)。需要注意的是,这只是起步价,高频使用下可能产生额外费用(详见 GitHub 讨论:What's the cost running it 24/7 for a month)。不过,作为一个 24 小时在线的 AI 服务,每月 5 美元的成本在可接受范围内。

直接点击 cf 一键部署 按钮开始初始化。

重要

务必修改并妥善保存 MOLTBOT_GATEWAY_TOKEN,这是后续进入管理后台的唯一凭证。

部署过程约需十分钟,期间可点击「继续处理项目」跳过等待页面。

访问网页界面需要配置 CF_ACCESS_AUD 和 CF_ACCESS_TEAM_DOMAIN 两个变量。

创建应用:进入 Zero Trust → Access → Applications,添加一个 Self-hosted 应用。

设置域名:

moltbot-sandbox。配置策略:通常系统会自动创建 moltbot-sandbox - Production 策略,默认通过邮箱验证码登录。

获取以上变量:

xxxxxx.cloudflareaccess.com。OpenClaw 需要 R2 来存储状态,需配置以下三个变量:

CF_ACCOUNT_IDR2_ACCESS_KEY_IDR2_SECRET_ACCESS_KEY操作步骤:

获取 Account ID:在 Cloudflare 侧边栏进入 R2 → Overview,右侧 Account Details 中的 Account ID 即为 CF_ACCOUNT_ID。

创建 API 令牌:点击 Manage R2 API Tokens,选择 Create API Token。

设置权限:权限选择 Object Read & Write,建议范围通过 Specific Bucket 限制在 moltbot-data。

保存密钥:创建成功后,记录 Access Key ID 和 Secret Access Key。

警告

修改 Token 时请务必核对变量名称。如果不慎修改了 Build Token,会导致 Worker 构建失败。

回到 Workers → Settings → Variables and Secrets,填入上述 5 个变量后,点击 Deploy 重新部署。

部署完成后,可通过以下地址访问 Worker(示例):

https://moltbot-sandbox.xxxxxxxx.workers.dev?token=MOLTBOT_GATEWAY_TOKEN通过 Cloudflare Access 的邮箱验证码验证后,即可进入管理后台并接受 Pairing Requests:

https://moltbot-sandbox.xxxxxxxx.workers.dev/_admin/

部署完成后,可以通过聊天指令与 Bot 交互。例如使用以下命令查看或切换模型:

/model minimax/MiniMax-M2.1为了避免 Worker 重启后模型被重置,建议设置开机自启命令:

set model minimax/MiniMax-M2.1远程终端连接示例:

openclaw gateway login --url https://moltbot-sandbox.xxxxxxxx.workers.dev

clawdbot configure --section skills实战中的「坑」:

国内 AI 服务商通常区分国内与海外端点。在 Cloudflare Workers 环境下,通过配置文件修改默认模型极易报错。在我的测试中,最稳妥的方案是直接通过开机命令强制指定模型,而非依赖配置文件或后台 UI。

折腾了一圈 Cloudflare Workers、本地虚拟机和浏览器自动化之后,我更清楚了一件事:

OpenClaw 目前还不是一个能「即刻提升效率」的工具。

现阶段,它更像是一个为 AI 自动化搭建的系统底座,而非开箱即用的产品。如果你没有明确的、可标准化的长流程需求,OpenClaw 带来的只会是维护成本,而非生产力红利。

如果你只是想验证技术可行性,Cloudflare Workers + OpenClaw 是一个低成本的尝鲜方案,适合:

但如果你期望它能「部署完就自动干活」,大概率会和我一样感到落差。

2026-01-28 08:00:00

ComfyUI 是目前最具扩展性的全平台 AI 绘画与视频生成工具。与其说它是一款软件,不如说这是一套以“节点流”(Node-based Workflow)为核心的可视化创作系统。在这里,模型、采样、控制与后处理不再是黑盒中的参数,而是可拆解、可组合、可复用的逻辑模块。

相比强调“开箱即用”的 WebUI,ComfyUI 的核心优势在于效率与硬件包容性。其内置的显存—内存交换机制(Smart Memory Management),能动态加载模型权重,将暂时闲置的数据卸载至内存。这种“以时间换空间”的策略,让 4GB 显存的老旧设备也能运行 SDXL 甚至 FLUX 等大模型,极大地降低了高画质生成的硬件门槛。

此外,ComfyUI 拥有极活跃的扩展生态。不仅兼容最新的扩散模型、SVD 视频生成与各类 ControlNet 控制节点,还能无缝接入 OpenAI、Gemini 等云端 API。本地算力不足时,可以通过节点将任务分发至云端,实现“混合算力”工作流。简言之,ComfyUI 不做预设,而是提供构建流水线的能力。

很多新手被满屏的连线劝退,误以为必须精通原理才能使用。这是最大的误解。

ComfyUI 的生态充满了现成的高质量工作流。作为创作者,首要任务是使用,而非制造。

在官方界面中,点击「模板」,你就能获得一套标准的 Text to Image 流程。填入提示词,点击运行即可生成。

当需要进阶功能时,直接去 Civitai 下载大家分享的 JSON 工作流文件,拖入窗口,使用 ComfyUI Manager 补全缺失节点,即可直接运行。

别被连线吓倒。连线是留给“开发者”的;对于“使用者”,ComfyUI 往往比 WebUI 更简单——因为它所见即所得,逻辑一目了然。

ComfyUI 支持 Windows、Linux、macOS。Windows 用户请直接下载 官方便携版 (Portable Standalone)。解压即用,自带独立 Python 环境,无需配置复杂的系统依赖。

解压后会看到多个启动脚本,请按需选择:

run_nvidia_gpu.bat:适合绝大多数 N 卡用户。run_nvidia_gpu_fast_fp16_accumulation.bat:如果你是 20/30/40 系显卡,这个脚本开启了 FP16 半精度累积计算,能显著提升速度并降低显存占用。(质量略降)run_cpu.bat:仅用 CPU 运行,速度较慢。国内直连 HuggingFace 速度较慢,推荐利用 ModelScope (魔搭社区) 镜像。

huggingface.co 替换为 modelscope.cn/models,即可享受满速下载。这是 ComfyUI 的“应用商店”,支持在界面内搜索、安装自定义节点,并能一键补全工作流缺失的插件。

安装:进入 ComfyUI/custom_nodes 目录,打开终端(CMD),运行:

git clone https://github.com/ltdrdata/ComfyUI-Manager.git使用:重启后菜单栏会出现 Manager 按钮,点击 「Install Missing Custom Nodes」 即可自动识别并安装当前工作流缺少的组件。

在生成高分辨率图像或视频时,物理内存极易枯竭导致闪退。强烈建议手动设置 Windows 虚拟内存。

推荐设置:初始大小与最大值均设为 32768(32GB) 或更高。

操作路径:

Win + R 输入 sysdm.cpl 打开系统属性。设置完成后建议重启一次(或至少重启 ComfyUI),避免旧的内存策略仍在生效。

ComfyUI 自带 HTTP API。只要程序正常启动,你就已经“开启”了 API。

本机访问:默认地址是 http://127.0.0.1:8188。

局域网访问(可选):启动时加上 --listen 0.0.0.0,例如:

python main.py --listen 0.0.0.0 --port 8188如果你用的是 Windows 便携版,思路相同:在对应的 run_*.bat 启动命令后追加 --listen 0.0.0.0 即可。

建议仅在可信内网使用,并配合防火墙限制来源;不要把 8188 端口直接暴露到公网。

API 调用的关键,是拿到“API 格式”的工作流 JSON(比普通保存更干净,不含界面坐标等元数据)。

workflow_api.json。

注意: 这个 JSON 文件与普通的

Save文件不同,它只包含节点 ID (class_type) 和输入参数 (inputs),没有界面坐标信息。

拿到 workflow_api.json 后,就可以基于 http://127.0.0.1:8188 通过以下端点提交任务与查询结果:

/prompt:发送工作流任务到队列。/history/{prompt_id}:获取任务执行结果。/view:获取生成的图片文件。/ws:用于实时监听生成进度和获取执行状态。尽管 ComfyUI 优化出色,但流畅运行 SVD 等视频模型仍需 12GB 以上显存。

对于高阶创作,不必执着于本地硬件。目前云端算力成本已大幅下降,将 ComfyUI 部署在云端(如 AutoDL、阿里云等)往往是更理性的选择——显存不再是瓶颈,生成效率可提升数倍。

ComfyUI 的核心价值不在于你拥有多少显卡,而在于掌握“工作流逻辑”。 一旦理解了节点间的流转关系,无论在本地 4090 还是云端 A100,你都能构建出独一无二的创作流水线。

2026-01-25 08:00:00

早年我将大量博客配图托管于七牛云,但当时并没有在本地对图片进行统一压缩。虽云端支持图片处理,但长期积累仍面临两个问题:

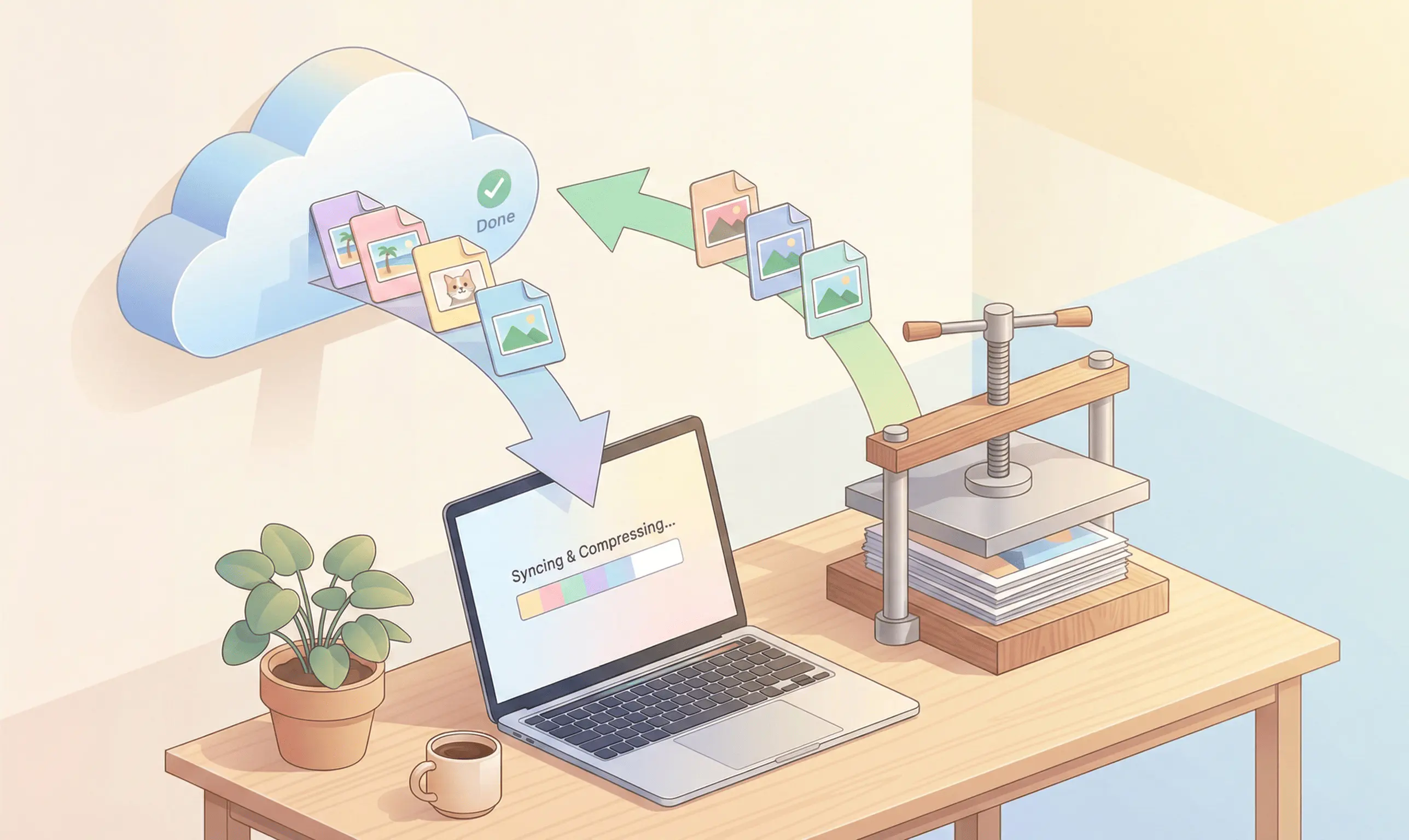

为此,我采用了一种更通用、可控的方案:「云端下行同步 → 本地批量压缩 → 上行覆盖同步」。此举既能压缩历史存量,又能建立一套可自由管理的图床库。

七牛云兼容 AWS S3 协议,可直接通过 Rclone 的 S3 Provider 访问,无需额外插件。

Rclone 是单文件命令行工具,无须安装,配置环境变量即可使用。

访问 Rclone 官网下载页,下载适用于 Windows 的 Intel/AMD - 64 Bit 压缩包。

将解压后的文件置于固定目录,例如 C:\rclone\,确保该目录下包含 rclone.exe。

Win 键,搜索「环境变量」,进入「编辑系统环境变量」。Path。C:\rclone\。启动 PowerShell 或 CMD,执行:

rclone --version输出版本号即表示配置成功。

注意:日常使用建议避免以管理员权限运行 PowerShell,以免权限冲突导致 Rclone 异常。

前置准备信息:

执行配置命令:

rclone config输入 n 新建远程连接(New remote)。

name:命名连接,例如 qiniu。

Storage:选择 S3(Amazon S3 Compliant Storage)。

provider:选择 Qiniu(Qiniu Object Storage)。

access_key_id:输入 AK。

secret_access_key:输入 SK。

region:留空回车。

endpoint:根据区域填写对应的接口地址(Endpoint):

| 区域 | Endpoint | | :

2026-01-24 08:00:00

从 LastPass 换到 KeePass 已经 5 年。作为一款老牌工具,KeePass 的优势有目共睹:开源免费、本地数据库存储、极高的定制自由度。然而,其痛点也不少:数据库需要自己同步,浏览器扩展更新停滞,自动填充也不稳定。

于是我尝试将密码管理方案迁移至 Bitwarden,并选择通过自托管 Vaultwarden 来替代官方订阅服务。Vaultwarden 是一个由社区维护的轻量级服务端实现,不仅兼容 Bitwarden 核心协议,更能完美适配官方客户端。其资源占用极低,可以部署于 NAS 或树莓派。彼时的我认为,这似乎是在“同步便利性”与“数据掌控权”之间找到的一个完美平衡点。

与 1Password、LastPass 等主流方案一致,Bitwarden 采用标准的「服务端 + 客户端」架构。所有凭据由云端(或自托管服务端)统一分发,实现了真正的实时多端同步。相比 KeePass 须时刻惦记“修改后同步数据库文件”的繁琐,Bitwarden 彻底抹平了这一认知负担。

Bitwarden 内置了完善的密码健康度分析、弱密码预警及泄露检测功能。它将分散的账户风险通过仪表盘集中呈现,方便用户及时处置潜在隐患。

无论是在浏览器扩展、桌面端还是移动 App,Bitwarden 都保持了高度统一的 UI 设计与交互逻辑。相较于 KeePass 浓重的“极客工具感”,Bitwarden 的操作路径更为清晰直观,即便是非技术用户也能迅速上手。

尽管纸面参数看似无懈可击,但在高频使用的真实场景中,一系列体验落差开始显现。

Bitwarden 的条目与文件夹强制依赖名称(A-Z)排序,完全缺失了 KeePass 中灵活的“自由拖拽排序”功能。若想将高频账号置顶,或按照个人习惯组织列表顺序,只能通过极其笨拙的重命名方式变相实现。

Bitwarden 的安全策略相对固化,例如对主密码复杂度的强制校验及繁琐的修改流程。相比之下,KeePass 赋予了用户对数据库加密算法、迭代次数及密钥文件组合的完全控制权,这种“丰俭由人”的开放性是 Bitwarden 难以企及的。

选择自托管 Vaultwarden,就意味着你得自己抗下服务器运维的苦活。相比之下,KeePass 搭配坚果云、OneDrive 等成熟的 WebDAV 服务,稳定性反而更有保障。毕竟个人的 NAS 或服务器难免遇到断电、断网或者硬盘故障。

折腾一圈之后,两者优劣已十分清晰:

| 维度 | Bitwarden | KeePass | | :

2026-01-23 08:00:00

帮你在客厅的大电视上,以极低的延迟畅玩书房高配电脑里的 3A 大作。

简单来说,就是把电脑(被控端)的画面实时传输到电视/手机/平板(控制端),并把手柄/键鼠的操作回传给电脑。相比 Steam Link,这套方案延迟更低、画质更好,支持 HDR 和 120Hz,是目前体验最好的局域网串流方案。

安装 Sunshine。安装完成后,Sunshine 会自动在后台运行。

安装 Moonlight。

https://localhost:47990),输入这个 PIN 码完成配对。很多新手遇到的最大问题是:电脑显示器是 1080P,电视是 4K,怎么让游戏在电视上以 4K 运行?

这里有三种方法,推荐程度依次递增:

这是最简单的方法,Moonlight 会告诉 Sunshine "我想要什么分辨率的画面"。

4K (3840x2160) 或 1080p。60 FPS(更稳定)或 120 FPS(更流畅,需网络支持)。如果你想让电视拥有完美的 4K HDR 体验,而不受物理显示器限制,安装 Sunshine 虚拟显示器驱动是最佳选择。

在 Sunshine 后台手动指定分辨率。

localhost:47990) -> Configuration。虽然理论上 5G Wi-Fi 带宽足够,但在我的实际测试中,无线连接的稳定性依然是最大瓶颈。

测试环境 1:同一房间,距离路由器约 3 米,使用 5G Wi-Fi。 结果:依然存在间歇性卡顿,即使我尝试降低分辨率和帧率,流畅度也没有达到完美预期。

测试环境 2:书房与客厅隔着两堵承重墙。 结果:卡顿明显,基本无法正常游玩。

结论: 虽然 Sunshine + Moonlight 方案上限很高,但对网络环境(尤其是延迟抖动)非常敏感。如果希望获得“如本地般丝滑”的体验,有线连接 依然是不可替代的终极解决方案。如果条件受限必须用 WiFi,请做好心理预期,或者尝试升级到更高端的 WiFi 7 路由器并独占频段。

2026-01-22 08:00:00

Notion 是一款非常优秀的工具,管理着我所有的 Mermaid 流程图。但在 Windows 平台上,其开机启动体验堪称灾难级别。

许多用户开机后都会遇到 Notion 自动启动却一片空白的现象。无论归咎于网络波动还是程序响应延迟,这种「死机般」的体验都极度影响使用好感。

对此,最彻底的解决思路只有一条:完全禁用 Notion 原生自启,转为通过脚本手动延时启动。

许多用户试图在 Notion 设置中关闭“开机启动”,却往往徒劳无功。事实上,该选项并未直接展示在设置面板中,而是隐藏在任务栏托盘图标的右键菜单里,名为「登录电脑时打开 Notion」。

更令人沮丧的是,这个开关存在明显缺陷——即便用户取消了勾选,重启电脑后它往往会自动复原。这一点在 Reddit 上已被大量用户证实。

既然软件内部的软开关失效,就必须通过 Windows 系统层级进行硬性管制。

Ctrl + Shift + Esc)。

此操作能从系统底层切断 Notion 的自启权限,彻底根除白屏困扰。

禁用自启虽然解决了白屏,但也意味着每次开机都需要手动打开软件。若通过脚本实现延时启动,则可兼顾“自动化”与“稳定性”——让 Notion 在系统和网络完全就绪后再运行。

新建一个文本文档,填入以下代码,并将文件后缀名修改为 .bat(例如 NotionDelay.bat):

@echo off

:: 等待 60 秒,确保网络连接就绪

timeout /t 60 /nobreak

:: 启动 Notion(请根据实际安装路径调整)

start "" "%LOCALAPPDATA%\Programs\Notion\Notion.exe"

exit提示:如果不确定 Notion 的具体安装路径,可在桌面 Notion 图标上点击 右键 -> 属性 -> 目标 进行查看。

Win + R 打开运行窗口。shell:startup 并回车,系统将打开「启动」文件夹。.bat 文件(或其快捷方式)放入该文件夹内。

配置完成后,脚本将在每次开机时自动运行并等待 60 秒。待系统负载稳定、网络畅通后,脚本才会唤起 Notion,从而确保软件界面极速加载,彻底告别白屏。